OpenAI GPT-4.1 시리즈 mini, nano 성능과 비용 비교 및 API 실무 활용법

OpenAI가 2025년 4월에 공개한 GPT-4.1 시리즈는 기존 GPT-4o 대비 지능, 속도, 비용, 멀티모달 이해 능력 측면에서 모두 향상된 모델군입니다.

🧠 GPT-4.1 시리즈 개요

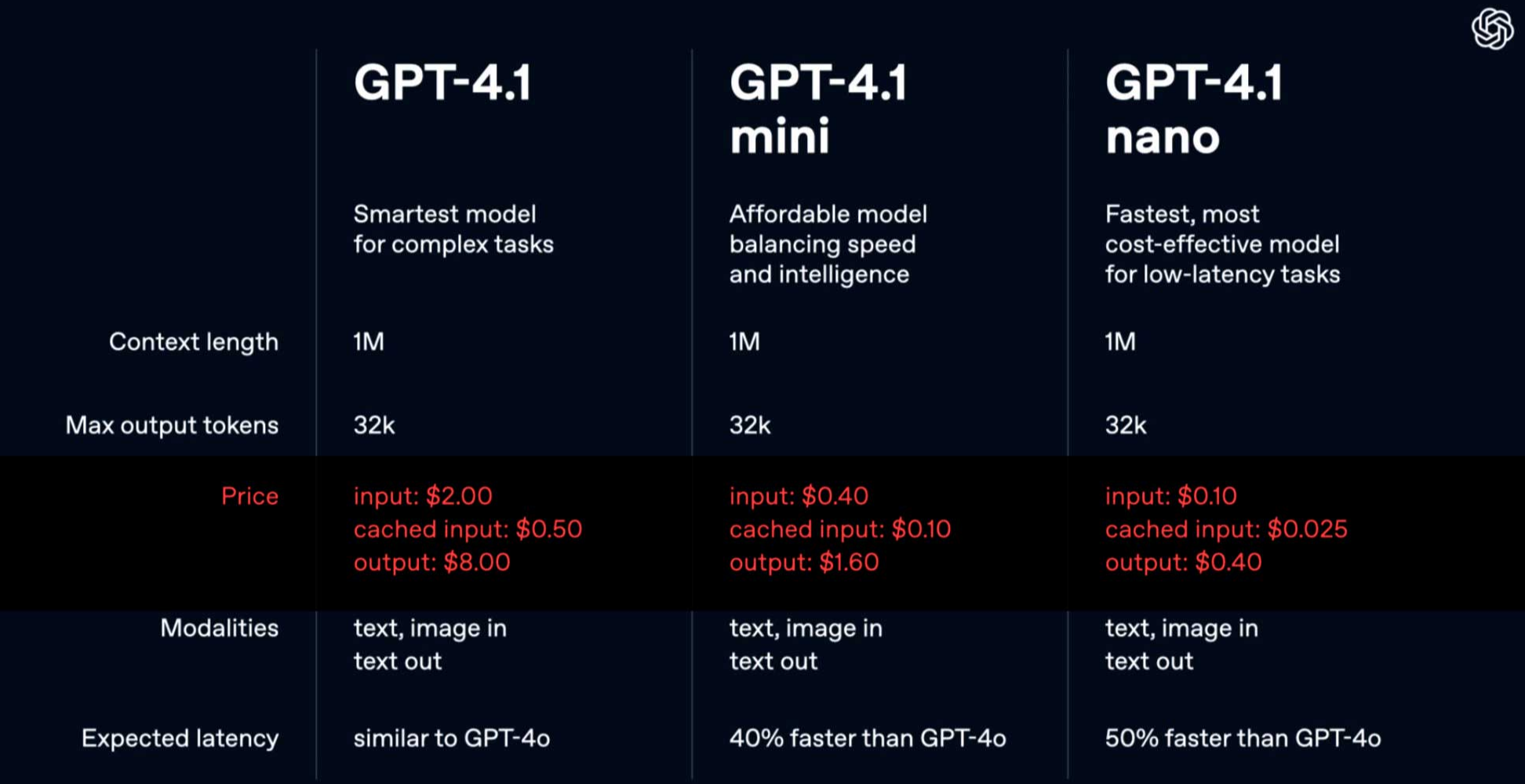

OpenAI는 다음의 세 가지 모델을 공개하였습니다.

- GPT-4.1

- GPT-4.1 mini

- GPT-4.1 nano

이 모델들은 모두 다음과 같은 공통 핵심 기능을 갖습니다.

- 최대 100만 토큰의 컨텍스트 윈도우 지원

- 낮은 지연 시간, 비용 절감, 향상된 지시 이해력 및 멀티모달 처리 성능

- 멀티모달 지원 (이미지, 비디오 포함)

🚀 성능 개선 요약

| 기능 | GPT-4.1 성능 | GPT-4o 대비 향상 |

|---|---|---|

| 코딩 능력 | SWE-bench Verified 54.6% | +21.4%p |

| 지시 따르기 | MultiChallenge 38.3% | +10.5%p |

| 긴 문맥 비디오 이해 | Video-MME (no subtitles): 72.0% | +6.7%p |

특히 SWE-bench는 GitHub 이슈 해결 능력을 평가하며, GPT-4.1은 상당한 개선을 보여줍니다.

📊 각 모델별 특징

🧩 GPT-4.1

- 주요 상용 모델

- GPT-4o보다 평균 26% 저렴

- 정밀한 멀티모달, 코드 처리, 문맥 유지에 탁월

⚙️ GPT-4.1 mini

- GPT-4o보다 지능이 더 뛰어난 평가 결과

- 지연 시간 절반, 비용 83% 절감

- 이미지 기반 벤치마크(MMMU, MathVista, CharXiv 등)에서도 더 높은 성능

- Video-MME 30~60분 자막 없는 영상 질문: 정확도 72.0%

🔌 GPT-4.1 nano

- 최소 비용 및 최소 지연 시간

- 여전히 고성능 유지, 임베디드/모바일 등 경량 환경 적합

💡 장기 문맥 및 멀티모달 이해

- 모든 모델: 최대 100만 토큰의 문맥을 유지

- 긴 기술 문서, 코드베이스, 보고서, 영상 등 복잡한 데이터에 적합

- 영상 기반 질의응답에서 뛰어난 정확도 확보

💰 가격 정책 (2025년 4월 기준)

모든 모델은 API로 공개되어 사용 가능하며, 프롬프트 캐시(같은 요청 반복 시) 할인 및 긴 문맥 추가 요금 없음 등의 혜택이 있습니다.

| 모델 | 입력 (백만 토큰당) | 출력 | 평균 비용 | 특이사항 |

|---|---|---|---|---|

| GPT-4.1 | $2.00 | $8.00 | 약 $1.84 | 고성능 메인 모델 |

| GPT-4.1 mini | $0.40 | $1.60 | 약 $0.42 | 비용 대비 성능 우수 |

| GPT-4.1 nano | $0.10 | $0.40 | 약 $0.12 | 최저 비용 |

- 프롬프트 캐시 할인: 기존 50% → 75%까지 확대

- 긴 문맥 처리에 추가 요금 없음 (단순 토큰 사용량 기준)

📅 GPT-4.5 Preview 종료 예정

- GPT-4.5 Preview는 2025년 7월 14일 종료

- OpenAI는 사용자들에게 GPT-4.1 시리즈로의 전환을 권장

🔐 보안과 엔터프라이즈 환경 고려 시 포인트

- 100만 토큰 문맥은 보안 정책 문서, 코드베이스 분석, 로그 분석 등에 최적

- nano 모델은 비용이 낮아 에이전트 기반 보안 시스템, 로컬 분석기 등에 적용 가능

- mini 모델은 성능과 비용의 균형이 뛰어나 보안 자동화 플랫폼, 챗봇, 지식 베이스 기반 대응에 적합

🧩 활용 사례 예시

- GPT-4.1: 복잡한 규정 문서 분석, 코드 리뷰 자동화, 대규모 지식 그래프 질의

- GPT-4.1 mini: 사용자 문의 응답, 내부 보안 규정 설명 챗봇, 정책서 자동화

- GPT-4.1 nano: IoT 디바이스 보안 이벤트 해석, 로컬 에이전트 지능화

OpenAI API에서 GPT-4.1 시리즈 사용하기

기본 구조 (chat/completions endpoint)

POST https://api.openai.com/v1/chat/completions

Authorization: Bearer YOUR_API_KEY

Content-Type: application/json{

"model": "gpt-4.1", // 또는 "gpt-4.1-mini", "gpt-4.1-nano"

"messages": [

{"role": "system", "content": "You are a helpful assistant."},

{"role": "user", "content": "GPT-4.1과 GPT-4o의 차이는 뭐야?"}

],

"temperature": 0.7,

"top_p": 1,

"max_tokens": 1024,

"stream": false

}사용 가능한 모델명

| 모델 | 호출 이름 |

|---|---|

| GPT-4.1 | "gpt-4.1" |

| GPT-4.1 mini | "gpt-4.1-mini" |

| GPT-4.1 nano | "gpt-4.1-nano" |

주요 파라미터 설명 및 튜닝 팁

| 파라미터 | 설명 | 추천값 (시나리오별) |

|---|---|---|

temperature |

창의성 조절 (낮을수록 결정적) | - 고객 응답: 0.3 - 콘텐츠 생성: 0.7~1.0 |

top_p |

출력 다양성 제어 (1이면 무제한) | 1.0 고정 추천 |

max_tokens |

응답 길이 제한 | 필요에 따라 조정 (ex. 2048~4096) |

presence_penalty |

새로운 주제 등장 확률 조절 | 0~1 (요약: 0, 창작: 0.6) |

frequency_penalty |

반복 억제 | 0 |

stream |

스트리밍 응답 여부 | 대화형 UI일 경우 true 권장 |

시나리오 기반 튜닝 전략

🎓 지식형 챗봇 (내부 문서 요약, 보안 가이드 제공 등)

"model": "gpt-4.1-mini",

"temperature": 0.3,

"max_tokens": 2048,

"top_p": 1,

"presence_penalty": 0.2gpt-4.1-mini로 충분히 정확도와 비용 균형 확보- 시스템 프롬프트에 보안 문서 스타일 추가 시 효과적

{"role": "system", "content": "You are a security expert providing precise, formal answers with citations."}

🤖 자동화 요약/리포트 생성기 (예: 회의록 요약, 로그 요약)

"model": "gpt-4.1",

"temperature": 0.2,

"top_p": 1,

"max_tokens": 4096- 긴 문맥 분석에 유리한

gpt-4.1사용 - 100만 토큰 컨텍스트로 긴 회의/문서 처리 가능

🧮 에이전트 연동형 경량 챗봇 (IoT, 보안 에이전트 응답)

"model": "gpt-4.1-nano",

"temperature": 0.5,

"max_tokens": 512- 응답 속도 및 비용 최적화

- 기본적인 질문/답변이나 경량형 운영 상태 응답에 적합

🧑💻 코딩 헬퍼 / 코드 리뷰 어시스턴트

"model": "gpt-4.1",

"temperature": 0.2,

"top_p": 1,

"max_tokens": 3072gpt-4.1은 SWE-bench 성능이 GPT-4o보다 21%p 이상 향상- 시스템 프롬프트

{"role": "system", "content": "You are an expert software engineer helping review and refactor Python code."}

💸 비용 최적화 팁

- 프롬프트 캐시 활성화 (OpenAI API 자동 적용): 동일 입력 요청 시 최대 75% 할인

- nano 또는 mini 모델로 다운그레이드하여 일일 요청량이 많은 서비스에 적용

- 긴 문맥 요청도 추가 비용 없음 (단, 사용 토큰에 따라 과금)

고급 설정 및 활용

함수 호출(Function Calling)

{

"model": "gpt-4.1",

"messages": [...],

"functions": [

{

"name": "get_weather",

"parameters": {

"type": "object",

"properties": {

"city": {"type": "string"}

},

"required": ["city"]

}

}

]

}- GPT-4.1 전 모델 함수 호출 지원 (OpenAI Functions API)

- 내부 시스템 자동화, API 호출형 응답 처리에 활용 가능

LangChain 사용법 (Python 기준)

설치

pip install langchain openai예제 코드

from langchain.chat_models import ChatOpenAI

from langchain.schema import HumanMessage

chat = ChatOpenAI(

model="gpt-4.1",

temperature=0.3,

openai_api_key="YOUR_API_KEY"

)

response = chat([HumanMessage(content="GPT-4.1 mini와 nano의 차이는?")])

print(response.content)chat = ChatOpenAI(model="gpt-4.1-mini")형태로 mini/nano도 지정 가능- LangChain에서 토큰 사용량 측정, 스트리밍, 툴 연동도 가능

OpenAI SDK 사용법

Python

pip install openai예제

import openai

openai.api_key = "YOUR_API_KEY"

response = openai.ChatCompletion.create(

model="gpt-4.1",

messages=[

{"role": "system", "content": "당신은 보안 전문가입니다."},

{"role": "user", "content": "멀티모달 지원이 무엇인가요?"}

],

temperature=0.5

)

print(response["choices"][0]["message"]["content"])Node.js (JavaScript/TypeScript)

npm install openai예제

const { OpenAI } = require("openai");

const openai = new OpenAI({ apiKey: "YOUR_API_KEY" });

async function askGPT() {

const chatCompletion = await openai.chat.completions.create({

model: "gpt-4.1-mini",

messages: [

{ role: "system", content: "You are a helpful assistant." },

{ role: "user", content: "GPT-4.1 nano는 어떤 용도에 적합한가요?" }

]

});

console.log(chatCompletion.choices[0].message.content);

}

askGPT();cURL 사용 예시

curl https://api.openai.com/v1/chat/completions \

-H "Content-Type: application/json" \

-H "Authorization: Bearer YOUR_API_KEY" \

-d '{

"model": "gpt-4.1-nano",

"messages": [

{"role": "user", "content": "GPT-4.1 nano로 할 수 있는 작업은?"}

]

}'브라우저 기반 JS (fetch 사용)

fetch("https://api.openai.com/v1/chat/completions", {

method: "POST",

headers: {

"Content-Type": "application/json",

"Authorization": "Bearer YOUR_API_KEY"

},

body: JSON.stringify({

model: "gpt-4.1-mini",

messages: [

{ role: "user", content: "GPT-4.1 mini와 GPT-4.1의 차이를 알려줘." }

]

})

})

.then(res => res.json())

.then(data => console.log(data.choices[0].message.content));함수 호출(Function Calling)

response = openai.ChatCompletion.create(

model="gpt-4.1",

messages=[

{"role": "user", "content": "서울의 날씨 알려줘."}

],

functions=[

{

"name": "get_weather",

"description": "도시의 현재 날씨를 반환",

"parameters": {

"type": "object",

"properties": {

"city": {"type": "string"}

},

"required": ["city"]

}

}

],

function_call="auto"

)유용한 팁

- 모델이 길고 복잡한 요청(예: 50만 토큰 이상)을 처리할 경우에도 추가 비용 없음

- 캐시된 요청은 75%까지 할인 적용됨 (자동 적용)

- 각 환경에서 스트리밍 모드나 Tool calling도 설정 가능

스트리밍 출력 처리

Python (OpenAI SDK)

pip install openaiimport openai

openai.api_key = "YOUR_API_KEY"

response = openai.ChatCompletion.create(

model="gpt-4.1",

messages=[{"role": "user", "content": "GPT-4.1에 대해 알려줘."}],

stream=True # ← 스트리밍 활성화

)

for chunk in response:

if 'choices' in chunk and chunk['choices'][0]['delta']:

print(chunk['choices'][0]['delta'].get('content', ''), end='', flush=True)💡 대규모 답변을 자연스럽게 보여주거나 실시간 UI 응답 시 유용합니다.

JavaScript (Node.js 기준)

const { OpenAI } = require("openai");

const openai = new OpenAI({ apiKey: "YOUR_API_KEY" });

async function streamChat() {

const stream = await openai.chat.completions.create({

model: "gpt-4.1",

messages: [{ role: "user", content: "GPT-4.1 시리즈의 특징은?" }],

stream: true,

});

for await (const part of stream) {

process.stdout.write(part.choices[0]?.delta?.content || "");

}

}

streamChat();LangChain에서 RetrievalQA, RAG, Agent 적용

RetrievalQA with OpenAI

from langchain.chat_models import ChatOpenAI

from langchain.vectorstores import FAISS

from langchain.chains import RetrievalQA

from langchain.embeddings import OpenAIEmbeddings

# 사전 구축된 FAISS 벡터 DB 로드

db = FAISS.load_local("faiss_index", OpenAIEmbeddings())

retriever = db.as_retriever()

qa = RetrievalQA.from_chain_type(

llm=ChatOpenAI(model="gpt-4.1", temperature=0),

retriever=retriever,

return_source_documents=True

)

result = qa.run("GPT-4.1 mini 모델이 적합한 상황은?")

print(result)RAG (Retrieval-Augmented Generation)

RAG는 Retrieval + LLM을 조합해 현실 기반 답변을 생성합니다.

- LangChain에서 RetrievalQA + 문서 요약 체인을 조합

- OpenAI Embedding + FAISS 또는 Chroma 등 사용

from langchain.chains import ConversationalRetrievalChain

from langchain.memory import ConversationBufferMemory

qa_chain = ConversationalRetrievalChain.from_llm(

llm=ChatOpenAI(model="gpt-4.1-mini"),

retriever=retriever,

memory=ConversationBufferMemory()

)

response = qa_chain({"question": "GPT-4.1 mini는 얼마나 빠른가요?"})

print(response["answer"])LangChain Agents

LangChain Agents는 여러 도구를 선택적으로 호출하는 Tool-Calling 기반 구조입니다.

from langchain.agents import initialize_agent, Tool

from langchain.tools import DuckDuckGoSearchRun

search = DuckDuckGoSearchRun()

tools = [Tool(name="Search", func=search.run, description="웹 검색 도구")]

agent = initialize_agent(

tools=tools,

llm=ChatOpenAI(model="gpt-4.1"),

agent="zero-shot-react-description",

verbose=True

)

agent.run("GPT-4.1 관련 최신 블로그를 검색해줘.")서버리스: Cloudflare Workers / Vercel / AWS Lambda

Cloudflare Workers

export default {

async fetch(request, env, ctx) {

const body = await request.json();

const res = await fetch("https://api.openai.com/v1/chat/completions", {

method: "POST",

headers: {

Authorization: `Bearer ${env.OPENAI_API_KEY}`,

"Content-Type": "application/json",

},

body: JSON.stringify({

model: "gpt-4.1-nano",

messages: body.messages,

}),

});

return new Response(await res.text(), { status: 200 });

},

};wrangler.toml에서 OPENAI_API_KEY 설정 필요

Vercel Edge Function

export const config = { runtime: "edge" };

export default async function handler(req) {

const body = await req.json();

const response = await fetch("https://api.openai.com/v1/chat/completions", {

method: "POST",

headers: {

Authorization: `Bearer ${process.env.OPENAI_API_KEY}`,

"Content-Type": "application/json",

},

body: JSON.stringify({

model: "gpt-4.1-mini",

messages: body.messages,

}),

});

return new Response(await response.text(), {

headers: { "Content-Type": "application/json" },

});

}AWS Lambda (Python)

import json

import openai

def lambda_handler(event, context):

openai.api_key = "YOUR_API_KEY"

body = json.loads(event['body'])

completion = openai.ChatCompletion.create(

model="gpt-4.1-nano",

messages=body["messages"]

)

return {

"statusCode": 200,

"body": json.dumps(completion["choices"][0]["message"]["content"])

}Lambda 함수는 openai 패키지 포함한 zip으로 배포하거나 Layer 사용

Prompt Engineering + System Role 전략

System Role 활용법

{"role": "system", "content": "당신은 보안 분석가입니다. 모든 답변은 정확하고 근거를 포함해야 합니다."}| 역할 | 예시 시스템 프롬프트 |

|---|---|

| 보안 분석가 | "당신은 IT 보안 전문가이며, 공격 유형과 대응 방안을 명확히 설명해야 합니다." |

| 기술 문서 작성기 | "당신은 DevOps 기술 작가입니다. 설명은 중급 개발자 수준으로 작성하세요." |

| 코드 리뷰어 | "당신은 숙련된 Python 개발자이며, 코드의 성능과 보안 취약점을 리뷰합니다." |

| 법률/규정 요약기 | "당신은 법률 문서 요약가이며, 조항을 간결하게 일반인이 이해할 수 있도록 변환합니다." |

Prompt 구성 전략

- 역할 지정 (

system) - 목표 명시 (

user) - 예시 제공 (

few-shot, optional)

예시: 보안 정책 생성기

[

{"role": "system", "content": "당신은 정보보호정책 전문가입니다."},

{"role": "user", "content": "중소기업용 USB 사용 정책을 생성해줘."}

]추가적으로 고려해 볼 수 있는 사항

- Tools 기반 Agent Customization

- LangChain에서 Chroma/Weaviate 기반 벡터 검색

- Web UI 프론트엔드 연동 (React 기반)

- 멀티모달 이미지/비디오 입력 구조

GPT-4.1 프롬프팅 가이드

– 고품질 응답을 이끌어내는 10가지 핵심 전략 –

1. 🎯 프롬프트의 목적과 맥락을 명확히 전달하세요

AI 모델이 상황을 정확히 이해하려면, 프롬프트의 배경과 목표가 명확해야 합니다.

- 좋은 프롬프트 예시

- “당신은 사이버 보안 컨설턴트입니다. 중소기업이 직면할 수 있는 일반적인 보안 위협과 그에 대한 대응책을 정리해주세요.”

- 명확히 해야 할 정보

- 문제의 배경

- 기대하는 결과물 형태 (예: 요약, 설명, 분석)

- 참고할 수 있는 컨텍스트나 이전 텍스트

2. 👩🏫 역할(Role)을 부여해 일관된 시각을 유도하세요

모델에게 특정 역할을 주면 답변의 톤과 정보 구성 방식이 일관되게 유지됩니다.

- 예시 문구

- “너는 친절한 초등학교 선생님이야. 10살 어린이에게 설명하듯이 알려줘.”

- “넌 보안팀장으로서, 담당자에게 정책 점검 가이드를 안내하는 역할이야.”

3. 🧱 구조화된 지시로 명확한 작업 흐름을 제시하세요

지시사항은 리스트나 번호 형태로 구조화할수록 AI가 이해하고 구성하기 쉬워집니다.

- 좋은 예시

- 아래 항목에 대해 순서대로 설명해줘

- 문제 정의

- 원인 분석

- 해결 방안

- 관련 사례

구조화는 정보 누락 방지에도 효과적입니다.

4. ✂️ 제약 조건을 명시해 출력 품질을 제어하세요

출력 길이, 표현 방식, 단어 선택 등에 명확한 제약을 부여하면 더 일관된 결과를 얻을 수 있습니다.

- 예시 문구

- “100자 이내 요약으로 작성해줘”

- “격식 있는 기업 보고서 스타일로 써줘”

- “전문 용어는 피하고 쉽게 설명해줘”

5. 🎨 톤과 문체를 구체적으로 지시하세요

AI의 말투, 어조, 표현 방식을 지정하면, 원하는 스타일의 문서를 쉽게 만들 수 있습니다.

- 예시 문구

- “친근한 말투로 대화하듯 써줘”

- “격식을 갖춘 이메일 형식으로 작성해줘”

- “부드럽고 신뢰감 있는 고객 안내문처럼 써줘”

6. 💡 예시(Prompt Sample)를 함께 제공하세요

모델이 어떤 응답을 원하는지 이해할 수 있도록, 좋은 예시와 나쁜 예시를 비교 제공하면 매우 효과적입니다.

- 예시

- ✅ 좋은 예시: “이 서비스는 사용자 데이터를 안전하게 암호화합니다.”

- ❌ 나쁜 예시: “데이터 그냥 저장함.”

직접 보여주는 것이 가장 빠른 학습 방법입니다.

7. 🪜 단계별 사고 유도 (Chain of Thought)

복잡하거나 다단계 문제는 AI에게 단계적으로 사고하도록 유도하세요.

- 예시 문구

- “먼저 핵심 개념을 설명하고, 다음 단계로 장단점을 정리해줘.”

- “단계별로 사고해서 결론까지 도달하는 과정을 보여줘.”

8. 🔁 반복적 프롬프팅으로 결과를 개선하세요

처음부터 완벽한 응답을 기대하기보단, 피드백을 반영하며 점진적으로 완성하는 접근이 좋습니다.

- 활용 예시

- “너무 길어요. 더 간단하게 정리해줘.”

- “예시를 하나 더 추가해줘.”

- “결론 부분만 다시 써줘.”

피드백-응답 사이클을 통해 정밀한 결과를 도출할 수 있습니다.

9. 🚧 모델 한계를 인식하고 보완하세요

모델은 맥락 길이 제한, 모호한 표현 오해, 사실 오류 등을 발생시킬 수 있습니다.

- 보완 방법

- 핵심 내용을 반복 강조

- 명확하지 않은 표현은 재질문으로 구체화

- 틀린 응답이 있으면 정정 지시를 직접 제공

10. 🧠 실전 적용을 위한 Best Practices

- 문장은 간결하고 명확하게 작성하세요.

- 키워드 중심으로 원하는 내용을 표현하세요.

- 프롬프트가 길다면 단계적으로 나눠서 요청하세요.

- 복잡한 요청일수록 실제 시나리오나 예시 상황을 포함시키는 것이 좋습니다.

“목적 + 역할 + 구조화 + 제약조건 + 톤 지시 + 예시 제공 + 단계적 사고 + 반복 피드백 + 한계 보완”

이 9가지 핵심 전략을 잘 조합하면, AI 모델을 도구가 아닌 정확한 업무 파트너로 활용할 수 있습니다.

프롬프트 설계는 곧 품질의 시작입니다.

잘 설계된 프롬프트는 여러분의 시간을 절약하고, 원하는 결과를 더 빠르게 얻는 지름길입니다.