ElastiFlow로 NetFlow/sFlow/IPFIX 기반 트래픽 분석과 보안 모니터링

🔍 ElastiFlow로 네트워크 트래픽을 한눈에!

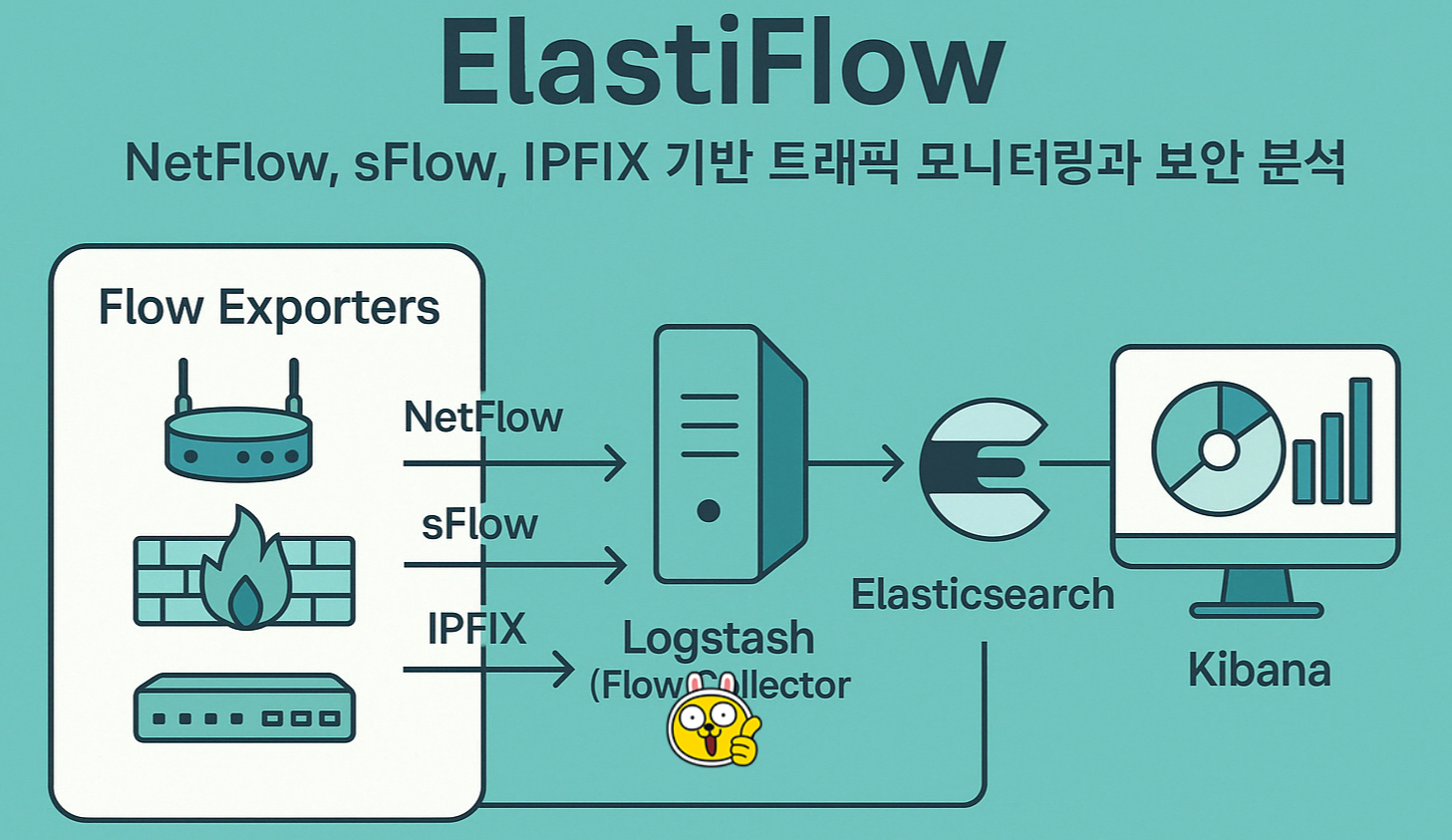

NetFlow, sFlow, IPFIX 기반 트래픽 모니터링과 보안 분석

ElastiFlow는 NetFlow, sFlow, IPFIX 등의 네트워크 흐름 데이터를 수집, 분석, 시각화할 수 있도록 해주는 오픈소스 네트워크 트래픽 분석 플랫폼으로, 보안 이상 탐지, 트래픽 분석, 네트워크 최적화 등 다양한 목적이며, 주로 Elastic Stack (Elasticsearch, Logstash, Kibana, Filebeat)을 기반으로 네트워크 트래픽 모니터링을 수행하며, 네트워크 보안 분석, 성능 모니터링 및 이상 탐지 등에 활용됩니다.

주요 기능

ElastiFlow는 주로 Elastic Stack을 활용하여 구성됩니다.

- 다양한 프로토콜 지원

- NetFlow v5/v9, IPFIX, sFlow 등 주요 프로토콜 지원 수집 가능

- 정교한 필터링/분석

- 네트워크 트래픽 유형, IP 주소별 분석, 포트 및 애플리케이션 프로토콜별 트래픽 분석

- 실시간 시각화

- Kibana 대시보드를 통해 트래픽 흐름을 한눈에 볼 수 있도록 시각화

- 보안 위협 탐지

- 비정상 트래픽, DDoS 징후 등 특정 패턴을 기반으로 비정상적인 트래픽 감지

- 확장성 보장

- Elastic Stack 기반이므로 데이터 저장, 분석, 확장성을 쉽게 조정 가능

- 다양한 네트워크 환경 지원

- 데이터센터, 클라우드 네트워크, 온프레미스 환경에서 활용 가능

ElastiFlow 아키텍처 구성

[Flow Exporters] → [Logstash + ElastiFlow 플러그인] → [Elasticsearch] → [Kibana]- Flow Exporters: 라우터, 방화벽 등에서 NetFlow/sFlow/IPFIX 데이터를 생성하고 Logstash로 전송

- Logstash: 수집 및 파싱, 정규화 한 네트워크 흐름 데이터를 변환하여 Elasticsearch로 전달

- Elasticsearch: 저장 및 검색 가능한 형태로 데이터 인덱싱 검색

- Kibana: 데이터 시각화 및 분석 대시보드 제공

설치 및 구성

ElastiFlow를 운영하기 위해 Elastic Stack과 함께 설정해야 합니다. 아래는 Ubuntu 서버에서 실행하는 방법입니다.

1) 필수 패키지 설치

sudo apt update

sudo apt install openjdk-11-jdk wget curl -y2) Elasticsearch 설치 및 구성

wget https://artifacts.elastic.co/downloads/elasticsearch/elasticsearch-8.4.3-amd64.deb

sudo dpkg -i elasticsearch-8.4.3-amd64.deb

sudo systemctl enable --now elasticsearch/etc/elasticsearch/elasticsearch.yml 수정

network.host: 0.0.0.0

cluster.name: elastiflow3) Logstash + ElastiFlow 설정

wget https://artifacts.elastic.co/downloads/logstash/logstash-8.4.3-amd64.deb

sudo dpkg -i logstash-8.4.3-amd64.deb

sudo systemctl enable --now logstashElastiFlow 설정 적용

git clone https://github.com/robcowart/elastiflow.git /etc/logstash/elastiflow

sudo cp /etc/logstash/elastiflow/logstash/elastiflow.conf /etc/logstash/conf.d/

sudo systemctl restart logstash4) Kibana 설치 및 구성

wget https://artifacts.elastic.co/downloads/kibana/kibana-8.4.3-amd64.deb

sudo dpkg -i kibana-8.4.3-amd64.deb

sudo systemctl enable --now kibana/etc/kibana/kibana.yml 수정

server.host: "0.0.0.0"

elasticsearch.hosts: ["http://localhost:9200"]Kibana에서 ElastiFlow 대시보드 설정

- 웹 브라우저에서

http://<서버IP>:5601접속 - Management → Stack Management → Index Patterns 에서

elastiflow-*생성 - Dashboards에서 제공되는 JSON 대시보드 Import

- Discover에서 실시간 흐름 확인 가능

보안 체크포인트

| 점검 항목 | 설명 |

|---|---|

| 수집 대상 제한 | 라우터/스위치/방화벽에서 전송하는 Flow 데이터의 범위 설정 |

| 비인가 접근 차단 | Elasticsearch/Kibana 접속 시 인증 설정 필수 (xpack.security.enabled: true) |

| 로그 보존 정책 | Flow 로그 데이터 보존 기간 및 인덱스 정책 정의 |

| 패턴 탐지 룰 설정 | DDoS, PortScan 등 이상 징후 탐지 룰 추가 가능 (Elasticsearch Watcher 또는 ML 기반 활용) |

| 관리자 권한 통제 | Kibana 사용자의 접근 권한 및 대시보드 편집권 분리 필요 |

활용 사례

- 네트워크 성능 분석

- 대역폭을 과도하게 사용하는 IP나 포트 탐지

- 보안 위협 탐지

- DDoS 징후, 이상 포트 스캔, 비인가 통신 감지

- 운영 최적화

- 부하 분산 조정, 정책 개선을 위한 데이터 기반 분석

ElastiFlow vs 다른 네트워크 모니터링 솔루션

| 기능 | ElastiFlow | ntopng | Grafana+Loki | Zabbix |

|---|---|---|---|---|

| 실시간 흐름 분석 | ✅ | ✅ | ❌ | ❌ |

| NetFlow 지원 | ✅ | ✅ | ❌ | ✅ |

| 고급 필터링 | ✅ | ✅ | ✅ | ✅ |

| 보안 위협 탐지 | ✅ | ❌ | ❌ | ✅ |

| 시각화 | ✅ (Kibana) | ✅ | ✅ | ✅ |

ElastiFlow는 네트워크 가시성 확보와 보안 분석 모두에 적합한 플랫폼입니다. Elastic Stack의 확장성과 시각화 기능을 그대로 활용할 수 있어 SOAR, ML 기반 자동화 대응까지 이어지는 고도화가 가능합니다.

추천 도입 대상

- 방화벽/라우터 트래픽 분석이 필요한 조직

- 실시간 보안 모니터링 강화가 필요한 보안팀

- 데이터센터 또는 클라우드 네트워크 운영팀

다음 단계 제안

- 📌 ML(Machine Learning) 기반 Anomaly Detection 기능 연계 (Elastic ML)

- 🔄 SOAR 연동을 통한 자동 차단 정책 연계

- 🛡️ Wazuh/Zeek 등 보안 솔루션과 연계하여 통합 보안 분석 강화

이번에는 MCP(Model Context Protocol)를 구성하여 AI와 연계하고, 자동화 환경을 구현하는 방법에 대한 예시입니다. MCP(Model Context Protocol)는 모델이 외부 환경(예: 애플리케이션, 플러그인, 툴 등)과 안전하고 표준화된 방식으로 상호작용할 수 있게 해주는 프로토콜입니다. 이를 활용하면 AI 모델(GPT, Gemini 등)이 보안 이벤트를 분석하거나, 티켓을 생성하거나, 알림을 전송하는 등의 작업을 직접 수행할 수 있습니다. 네트워크 트래픽 모니터링, 이상 탐지, 자동 조치가 가능합니다.

시나리오 개요

“내부 네트워크에서 비정상적인 포트 스캔 또는 외부 DDoS 전조 트래픽이 탐지되면, AI가 이를 판단하고 방화벽에 자동으로 차단 정책을 적용하며, 이후 보고서까지 자동 생성되게 하고 싶다.”

이를 위해 필요한 요소는 다음과 같습니다.

| 구성 요소 | 역할 |

|---|---|

| Wazuh/Zeek | 네트워크 흐름 및 이벤트 수집 |

| Elastic Stack (ElastiFlow 포함) | 시각화 및 이벤트 보관 |

| GPT 기반 AI | 이벤트 해석, 조치 판단 |

| MCP 서버 | AI ↔ 제어 시스템 간 통신 연결자 |

| 방화벽 연동 API (예: pfSense, Palo Alto) | 실제 네트워크 차단 적용 |

| SOAR 연계 (선택) | 티켓 발급 및 추후 분석 자동화 |

구성 아키텍처

[Wazuh / ElastiFlow / Zeek]

↓ (이벤트 탐지)

[MCP Plugin]

↓ (OpenAPI 호출)

[GPT AI 분석]

↓ (차단 판단)

[방화벽 API / Slack 알림 / 리포트 자동 생성]예시: 내부 포트 스캔 탐지 시 자동 조치

1. Wazuh 또는 Zeek에서 아래와 같은 이벤트 발생

{

"src_ip": "192.168.10.200",

"dst_ports": [22, 23, 80, 443, 3306, 3389],

"event": "Possible Port Scan Detected",

"timestamp": "2025-04-20T02:03:00Z"

}2. 해당 이벤트가 MCP 서버를 통해 GPT에 전달

MCP가 사용하는 OpenAPI 명세 예시

paths:

/portscan-response:

post:

summary: 포트스캔 탐지 대응 요청

requestBody:

content:

application/json:

schema:

type: object

properties:

src_ip:

type: string

dst_ports:

type: array

items:

type: integer

responses:

'200':

description: 대응 완료3. AI의 판단 예시 (GPT 응답 예측)

{

"block_ip": true,

"risk_level": "high",

"recommended_action": "Firewall 차단 + 알림 + SOC 티켓 등록"

}4. 자동화된 조치 흐름

| 단계 | 동작 예시 | 연동 도구 |

|---|---|---|

| 1 | 방화벽에서 192.168.10.200 차단 |

pfSense API 호출: POST /api/v1/firewall/block_ip |

| 2 | Slack에 알림 발송 | Webhook 통해 자동 메시지 |

| 3 | TheHive에 티켓 생성 | POST /api/alert |

| 4 | Kibana에 대응 내용 기록 | Elasticsearch에 JSON 로그 삽입 |

🧠 GPT Plugin 설정 (MCP 연동)

{

"schema_version": "v1",

"name_for_model": "network_guardian",

"name_for_human": "네트워크 AI 가디언",

"description_for_model": "네트워크 트래픽 이벤트를 분석하고 차단, 알림, 리포트를 자동으로 생성합니다.",

"api": {

"type": "openapi",

"url": "https://mcp.internal/api-docs.yaml"

},

"auth": {

"type": "none"

}

}📑 결과 예시 (자동 생성 보고서 요약)

📍 포트 스캔 탐지

- 탐지 시각: 2025-04-20 11:03:00

- 출발지 IP: 192.168.10.200

- 탐지 포트: 22, 23, 80, 443, 3306, 3389

- 위험도: High

- 조치 사항

- 방화벽 차단 완료

- Slack 알림 전송

- 티켓 자동 등록 (TheHive)

🔐 보안 체크포인트

| 항목 | 설명 |

|---|---|

| 인증 및 권한 제어 | MCP 호출 시 IP allowlist 또는 API Key 필요 |

| 로그 감사 | AI 명령 요청/응답 모두 중앙 로그로 기록 |

| 차단 정책 검증 | 차단된 IP 및 사유 기록 유지, 롤백 가능하게 구성 |

| 사용자 개입 포인트 | 자동 조치 외 수동 검토도 가능하도록 구조화 |

| AI 응답 검증 | GPT 응답을 정규화하고 유효성 검증 단계 포함해야 함 |

🔄 확장 아이디어

- 🧠 AI 기반 DGA 도메인 탐지 후 DNS 블록 자동화

- 🌐 VPN 연결 사용자 중 이상 트래픽 분석 후 계정 정지 자동화

- 🔐 IDS 탐지 → AI 분류 → 침해 사고 여부 판단 → Wazuh에 이벤트 전송

- 📊 월별 자동 보고서 생성 후 Google Drive 또는 Notion 업로드

MCP 기반 자동화는 GPT와 같은 LLM이 네트워크 이벤트를 분석하고 직접 액션을 수행하게 만들어줍니다. 이는 단순 SIEM 분석을 넘어 행동 중심의 SOAR 기능을 AI가 수행하게 되는 구조이며, 보안 업무 효율성을 비약적으로 끌어올릴 수 있습니다.

(참고) pfSense API 연동 샘플 mcp-server 코드 (Python/Flask 기반)

# MCP 서버 샘플 (Python + Flask)

from flask import Flask, request, jsonify

import requests

app = Flask(__name__)

# pfSense API 정보

PFSENSE_API_URL = "http://pfsense.local/api/firewall/block_ip"

PFSENSE_API_TOKEN = "Bearer YOUR_PFSENSE_API_TOKEN"

# TheHive API (선택)

THEHIVE_API_URL = "http://thehive.local/api/alert"

THEHIVE_API_KEY = "YOUR_HIVE_KEY"

# Slack Webhook (선택)

SLACK_WEBHOOK = "https://hooks.slack.com/services/XXX/YYY/ZZZ"

@app.route("/portscan-response", methods=["POST"])

def handle_portscan():

data = request.json

src_ip = data.get("src_ip")

dst_ports = data.get("dst_ports", [])

# 1. pfSense 차단

pf_payload = {"ip": src_ip}

pf_headers = {"Authorization": PFSENSE_API_TOKEN}

pf_response = requests.post(PFSENSE_API_URL, json=pf_payload, headers=pf_headers)

# 2. Slack 알림

slack_msg = {

"text": f"[Port Scan Detected] {src_ip} -> Ports: {dst_ports}\nBlocked on pfSense."

}

requests.post(SLACK_WEBHOOK, json=slack_msg)

# 3. TheHive 티켓 등록

hive_alert = {

"title": "Port Scan Detected",

"description": f"{src_ip} attempted scan on {dst_ports}",

"source": "MCP",

"type": "external",

"severity": 2,

"tlp": 2,

"tags": ["portscan", "auto-block"],

"sourceRef": f"portscan-{src_ip}"

}

hive_headers = {"Authorization": f"Bearer {THEHIVE_API_KEY}"}

requests.post(THEHIVE_API_URL, json=hive_alert, headers=hive_headers)

return jsonify({"result": "actions completed", "blocked_ip": src_ip})

if __name__ == "__main__":

app.run(host="0.0.0.0", port=8000)