시스템 환경 설정 관리의 진화

윈도우 레지스트리의 개념과 역할

윈도우 레지스트리는 Microsoft Windows 운영 체제에서 시스템 및 애플리케이션 설정 정보를 저장하는 중앙집중식 계층형 데이터베이스입니다. 이는 운영 체제, 애플리케이션, 사용자 설정, 하드웨어 정보 등 Windows 시스템 전반의 구성 정보를 관리하는 통합된 저장소 역할을 합니다.

- 계층적 구조: 트리 형태로 정보를 저장하여 효과적인 카테고리화 지원

- 중앙집중식 관리: 설정 정보를 한 곳에서 통합 관리

- 표준화된 접근 방식: 레지스트리 API를 통한 일관된 접근

- 자동 로드/저장: 시스템과 함께 자동으로 관리되는 영구 저장소

윈도우 레지스트리는 이런 통합된 접근 방식으로 시스템 설정의 일관성을 유지하고, 애플리케이션이 설정을 저장/로드하는 표준화된 방법을 제공합니다.

리눅스 환경에서의 전통적 시스템 설정 관리 방식

리눅스 환경에서는 전통적으로 파일 기반 설정 관리 방식을 사용해 왔습니다.

- /etc 디렉토리: 시스템 전반의 설정 파일 보관

- /etc/sysconfig: Red Hat 계열 시스템 설정

- /etc/default: Debian 계열 기본 설정

- 홈 디렉토리 내 설정 파일: 사용자별 설정(

.bashrc,.config/등) - systemd 단위 파일: 서비스 설정과 관리

문제점

- 분산된 설정 파일: 다양한 위치와 형식으로 인한 관리 복잡성

- 일관성 부재: 애플리케이션마다 다른 설정 파일 형식(INI, XML, YAML, JSON 등)

- 변경 추적의 어려움: 설정 변경 이력 관리 부재

- 분산 환경 대응 한계: 여러 서버 간 설정 동기화의 어려움

이러한 문제는 복잡한 시스템과 분산 환경이 늘어나면서 더욱 심화되었습니다.

현대적 시스템 환경: 컨테이너와 분산 시스템

Docker와 Kubernetes 환경의 특징

Docker와 Kubernetes의 도입으로 시스템 환경 관리 패러다임이 크게 변화했습니다.

- 이미지 기반 배포: 애플리케이션과 의존성을 패키징한 불변(immutable) 이미지 사용

- 선언적 구성: YAML 기반 구성 파일로 인프라와 애플리케이션 정의

- 동적 환경: 자동 확장, 복제, 롤링 업데이트 등 지속적 변화

- 분산 아키텍처: 마이크로서비스와 다중 클러스터 환경

- 오케스트레이션: 컨테이너 생명주기 자동 관리

이러한 새로운 환경에서는 기존의 파일 기반 설정 관리 방식이 다음과 같은 한계를 보입니다.

- 확장성 문제: 수백, 수천 개의 서비스 설정 관리의 어려움

- 동적 변경 대응 한계: 실시간 설정 변경과 전파 메커니즘 부재

- 설정 불일치: 서비스 간, 환경 간 설정 불일치 발생 가능성

- 중앙 관리 부재: 분산된 설정으로 인한 가시성 부족

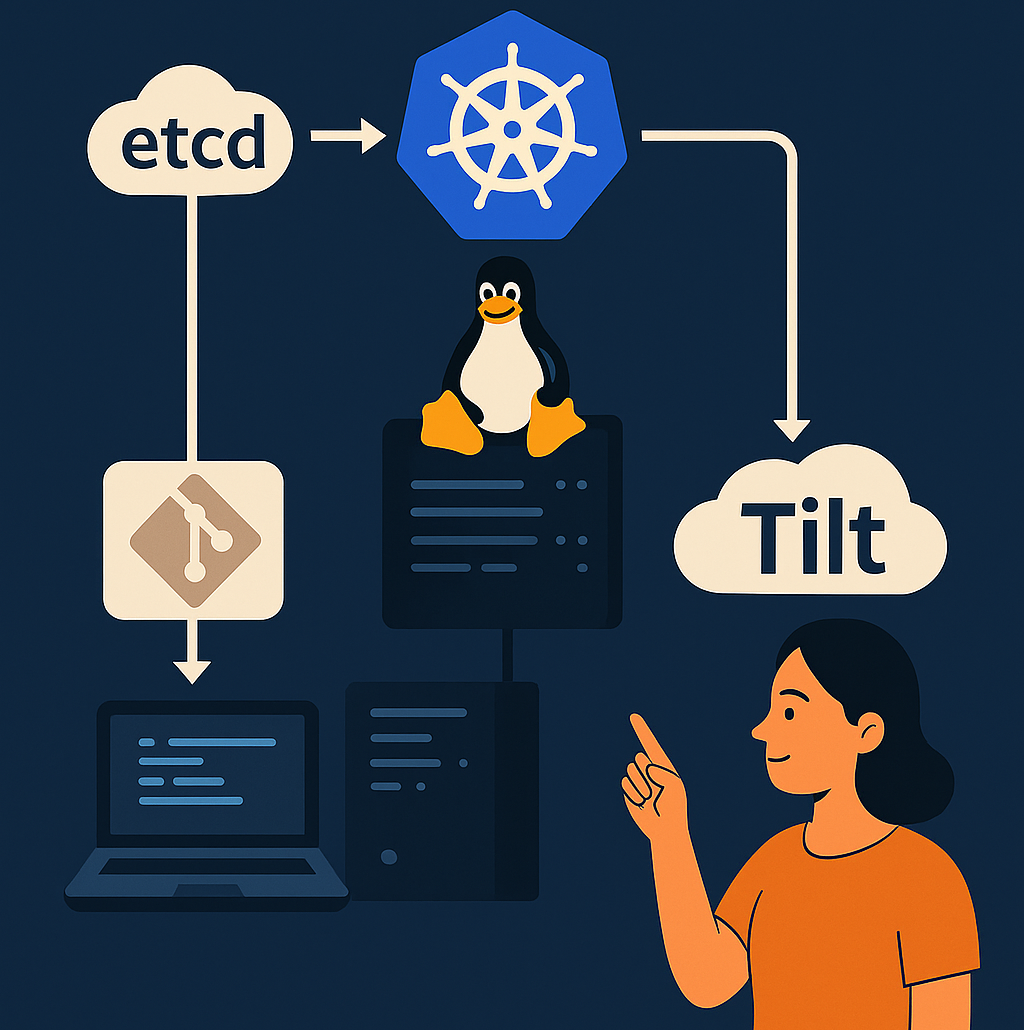

etcd: 분산 환경에서의 중앙화된 설정 관리

etcd의 개념과 핵심 기능

etcd는 분산 시스템을 위한 안정적인 분산형 키-값 저장소로, Kubernetes와 같은 대규모 분산 시스템의 핵심 구성 요소입니다.

- 분산 합의 알고리즘(Raft): 노드 간 데이터 일관성 보장

- 키-값 저장소: 단순하고 효율적인 데이터 관리

- 계층적 키 구조: 폴더와 유사한 조직화 지원

- 변경 감시(Watch): 실시간 설정 변경 알림

- TTL과 리스(Lease): 임시 키와 자동 만료 지원

- 트랜잭션: 원자적 읽기-수정-쓰기 연산 지원

etcd를 활용한 설정 관리 구현

Docker로 단일 노드 etcd 실행

docker run -d \

-p 2379:2379 \

-p 2380:2380 \

--name etcd quay.io/coreos/etcd:v3.5.0 \

/usr/local/bin/etcd \

--name s1 \

--data-dir /etcd-data \

--listen-client-urls http://0.0.0.0:2379 \

--advertise-client-urls http://0.0.0.0:2379 \

--listen-peer-urls http://0.0.0.0:2380 \

--initial-advertise-peer-urls http://0.0.0.0:2380 \

--initial-cluster s1=http://0.0.0.0:2380 \

--initial-cluster-token tkn \

--initial-cluster-state new고가용성 etcd 클러스터 구성 (3노드 예시)

# docker-compose.yml

version: '3'

services:

etcd1:

image: quay.io/coreos/etcd:v3.5.0

command:

- /usr/local/bin/etcd

- --name=etcd1

- --initial-advertise-peer-urls=http://etcd1:2380

- --listen-peer-urls=http://0.0.0.0:2380

- --listen-client-urls=http://0.0.0.0:2379

- --advertise-client-urls=http://etcd1:2379

- --initial-cluster=etcd1=http://etcd1:2380,etcd2=http://etcd2:2380,etcd3=http://etcd3:2380

- --initial-cluster-state=new

ports:

- "2379:2379"

etcd2:

image: quay.io/coreos/etcd:v3.5.0

command:

- /usr/local/bin/etcd

- --name=etcd2

- --initial-advertise-peer-urls=http://etcd2:2380

- --listen-peer-urls=http://0.0.0.0:2380

- --listen-client-urls=http://0.0.0.0:2379

- --advertise-client-urls=http://etcd2:2379

- --initial-cluster=etcd1=http://etcd1:2380,etcd2=http://etcd2:2380,etcd3=http://etcd3:2380

- --initial-cluster-state=new

etcd3:

image: quay.io/coreos/etcd:v3.5.0

command:

- /usr/local/bin/etcd

- --name=etcd3

- --initial-advertise-peer-urls=http://etcd3:2380

- --listen-peer-urls=http://0.0.0.0:2380

- --listen-client-urls=http://0.0.0.0:2379

- --advertise-client-urls=http://etcd3:2379

- --initial-cluster=etcd1=http://etcd1:2380,etcd2=http://etcd2:2380,etcd3=http://etcd3:2380

- --initial-cluster-state=new기본적인 설정 관리

# 설정 저장

etcdctl put /config/database/url "mysql://user:password@db.example.com:3306/mydb"

etcdctl put /config/api/timeout "30s"

etcdctl put /config/features/dark-mode "enabled"

# 설정 조회

etcdctl get /config/database/url

etcdctl get --prefix /config/api/

# 설정 감시

etcdctl watch --prefix /config/프로그래밍 방식 접근 (Python 예시)

import etcd3

# 클라이언트 연결

client = etcd3.client(host='localhost', port=2379)

# 설정 저장

client.put('/config/app/log-level', 'info')

# 설정 조회

value, _ = client.get('/config/app/log-level')

print(f"Log level: {value.decode('utf-8')}")

# 설정 변경 감시

def watch_callback(event):

print(f"설정 변경: {event.key.decode('utf-8')} = {event.value.decode('utf-8')}")

watch_id = client.add_watch_callback('/config/app', watch_callback)

# 설정 변경 자동 적용 예시

import threading

import time

def refresh_config():

while True:

try:

log_level, _ = client.get('/config/app/log-level')

app.logger.setLevel(log_level.decode('utf-8'))

except Exception as e:

print(f"설정 갱신 오류: {e}")

time.sleep(30) # 30초마다 갱신

# 백그라운드 스레드로 설정 갱신

threading.Thread(target=refresh_config, daemon=True).start()etcd 보안은 매우 중요합니다. Kubernetes의 핵심 데이터를 저장하므로 철저한 보안 설정이 필요합니다.

# 인증서 생성 (간략 예시)

mkdir -p /etc/etcd/ssl

cd /etc/etcd/ssl

# CA 인증서 생성

openssl genrsa -out ca.key 4096

openssl req -x509 -new -nodes -key ca.key -sha256 -days 365 -out ca.crt -subj "/CN=etcd-ca"

# 서버 인증서 생성

openssl genrsa -out server.key 4096

openssl req -new -key server.key -out server.csr -subj "/CN=etcd-server"

openssl x509 -req -in server.csr -CA ca.crt -CAkey ca.key -CAcreateserial -out server.crt -days 365

# 클라이언트 인증서 생성

openssl genrsa -out client.key 4096

openssl req -new -key client.key -out client.csr -subj "/CN=etcd-client"

openssl x509 -req -in client.csr -CA ca.crt -CAkey ca.key -CAcreateserial -out client.crt -days 365TLS 적용 etcd 실행

etcd --name s1 \

--data-dir /var/lib/etcd \

--cert-file=/etc/etcd/ssl/server.crt \

--key-file=/etc/etcd/ssl/server.key \

--trusted-ca-file=/etc/etcd/ssl/ca.crt \

--client-cert-auth \

--listen-client-urls https://0.0.0.0:2379 \

--advertise-client-urls https://etcd.example.com:2379인증서 기반 클라이언트 연결

etcdctl --endpoints=https://etcd.example.com:2379 \

--cacert=/etc/etcd/ssl/ca.crt \

--cert=/etc/etcd/ssl/client.crt \

--key=/etc/etcd/ssl/client.key \

get /config/app/log-leveletcd 기반 애플리케이션 설계 패턴

etcd를 활용한 효과적인 설정 관리를 위한 설계 패턴들

계층적 설정 구조

/config/

/global/ # 전체 환경 공통 설정

database-url

api-version

/env/ # 환경별 설정

/prod/

log-level

cache-ttl

/dev/

log-level

feature-flags

/service/ # 서비스별 설정

/auth-service/

token-expiry

/payment-service/

payment-gateway설정 동적 갱신 패턴

- Watch 기반 즉시 갱신: 설정 변경 시 즉시 반영

- 주기적 폴링: 안정성을 위해 주기적으로 설정 확인

- 하이브리드 접근법: Watch와 주기적 폴링 조합

설정 버전 관리

/config/service/auth/

current # 현재 사용 중인 버전 ID (v2)

/v1/

token-expiry: 3600

/v2/

token-expiry: 7200

/v3/ # 준비 중인 새 버전

token-expiry: 10800Tilt: 마이크로서비스 개발 환경 자동화

Tilt의 개념과 역할

Tilt는 Kubernetes 기반 마이크로서비스 개발을 위한 오픈소스 도구로, 코드 변경에서 배포까지의 과정을 자동화하여 개발 생산성을 크게 향상시킵니다.

- 코드 변경 감지 및 자동 재빌드/재배포

- 다중 서비스 조율 및 의존성 관리

- 통합 로그 뷰 및 디버깅 도구

- 로컬 개발 환경과 Kubernetes 연계

- 선언적 설정을 통한 재현 가능한 개발 환경

Tilt 설정 및 사용

Tilt 설치

# Linux

curl -fsSL https://raw.githubusercontent.com/tilt-dev/tilt/master/scripts/install.sh | bash

# macOS

brew install tilt-dev/tap/tilt

# Windows (PowerShell)

iex ((new-object net.webclient).DownloadString('https://raw.githubusercontent.com/tilt-dev/tilt/master/scripts/install.ps1'))단일 서비스 Tiltfile 예시

# Tiltfile

# 이미지 빌드 설정

docker_build('myapp', '.',

live_update=[

sync('.', '/app'),

run('cd /app && npm install', trigger=['package.json']),

restart_container()

]

)

# Kubernetes 배포 설정

k8s_yaml('kubernetes/deployment.yaml')

k8s_resource('myapp', port_forwards='8080:8080')다중 마이크로서비스 Tiltfile

# 복잡한 마이크로서비스 환경 Tiltfile

# 프론트엔드 서비스

docker_build(

'frontend',

'./frontend',

live_update=[

sync('./frontend/src', '/app/src'),

run('cd /app && npm install', trigger=['package.json']),

restart_container()

]

)

# 백엔드 API 서비스

docker_build(

'backend',

'./backend',

live_update=[

sync('./backend/src', '/app/src'),

run('cd /app && pip install -r requirements.txt', trigger=['requirements.txt']),

restart_container()

]

)

# 인증 서비스

docker_build(

'auth-service',

'./auth-service',

live_update=[

sync('./auth-service/src', '/app/src'),

restart_container()

]

)

# 환경 변수 설정

os.environ['DATABASE_URL'] = 'postgresql://user:password@localhost:5432/mydb'

# 쿠버네티스 리소스 배포

k8s_yaml(kustomize('./kubernetes'))

# 리소스 종속성 및 포트 포워딩 설정

k8s_resource('frontend', port_forwards='3000:3000', resource_deps=['backend'])

k8s_resource('backend', port_forwards='8080:8080', resource_deps=['auth-service', 'database'])

k8s_resource('auth-service', port_forwards='8081:8081')

k8s_resource('database', port_forwards='5432:5432')

# 로컬 개발 리소스 (예: 프론트엔드 개발 서버)

local_resource(

'frontend-dev',

'cd frontend && npm run dev',

deps=['./frontend/src'],

serve_cmd='cd frontend && npm run dev',

links=['http://localhost:3000']

)Tilt와 etcd 통합

Tilt와 etcd를 통합하여 개발 환경에서도 중앙화된 설정 관리를 구현할 수 있습니다:

# Tiltfile with etcd integration

# etcd 배포

k8s_yaml('./kubernetes/etcd.yaml')

k8s_resource('etcd', port_forwards='2379:2379')

# 설정 초기화 스크립트

local_resource(

'init-config',

'./scripts/init-etcd-config.sh',

resource_deps=['etcd']

)

# 애플리케이션 서비스 (etcd에서 설정 로드)

docker_build('config-service', './config-service')

docker_build('api-gateway', './api-gateway')

# Kubernetes 리소스 배포

k8s_yaml('./kubernetes/services.yaml')

# 종속성 설정 (config-service가 먼저 준비되어야 함)

k8s_resource('config-service', resource_deps=['etcd', 'init-config'])

k8s_resource('api-gateway', resource_deps=['config-service'])etcd 설정 초기화 스크립트

#!/bin/bash

# ./scripts/init-etcd-config.sh

# etcd가 준비될 때까지 대기

until etcdctl endpoint health; do

echo "Waiting for etcd to be ready..."

sleep 2

done

# 개발 환경 기본 설정 로드

etcdctl put /config/database/url "postgresql://dev:dev@postgres:5432/devdb"

etcdctl put /config/api/timeout "10000"

etcdctl put /config/feature-flags/experimental "true"

echo "Development configuration loaded into etcd"Tilt를 활용한 개발 워크플로우 최적화

Tilt를 사용한 효율적인 개발 워크플로우

- 통합 개발 환경 시작:

tilt up명령어로 전체 마이크로서비스 환경 구동 - 코드 수정: 로컬 코드 변경 시 실시간 동기화 및 재배포

- 통합 로그 모니터링: Tilt UI에서 모든 서비스 로그 확인

- 디버깅: 포트 포워딩을 통한 로컬 디버깅

- 환경 종료:

tilt down으로 전체 환경 정리

시스템 형상 관리의 효과적인 접근법

GitOps 방식의 설정 관리

GitOps는 Git을 통해 인프라와 애플리케이션 설정을 선언적으로 관리하는 방법론입니다.

핵심 원칙

- 선언적 접근: 시스템의 목표 상태를 선언적으로 정의

- 버전 제어: 모든 설정을 Git에서 버전 관리

- 자동 동기화: Git 저장소와 실행 환경 간 자동 동기화

- 변경 감지: 차이점 감지 및 수정 자동화

구현 도구

- Flux CD: 경량화된 GitOps 자동화 도구

- ArgoCD: Kubernetes를 위한 선언적 GitOps CD 도구

- JenkinsX: Kubernetes 기반 CD 솔루션

Kubernetes와 etcd 기반 형상 관리 아키텍처

형상 관리 계층 구조

- Git 저장소: 모든 설정의 신뢰할 수 있는 단일 소스

- 인프라 코드(IaC): Terraform, Pulumi 등

- Kubernetes 매니페스트: Helm 차트, Kustomize 등

- 애플리케이션 설정: ConfigMap, Secret 템플릿

- CI/CD 파이프라인: 변경 검증 및 자동화

- 구문 검사 및 정적 분석

- 보안 취약점 스캔

- 테스트 환경 배포 및 검증

- GitOps 컨트롤러: 실행 환경과 Git 저장소 동기화

- ArgoCD/Flux: Kubernetes 클러스터와 Git 저장소 동기화

- 변경 탐지 및 자동 적용

- 설정 저장소(etcd): 런타임 설정 및 동적 구성

- 애플리케이션 설정 저장

- 서비스 디스커버리 정보

- 상태 정보

ArgoCD 애플리케이션 정의

# argo-app.yaml

apiVersion: argoproj.io/v1alpha1

kind: Application

metadata:

name: my-microservices

namespace: argocd

spec:

project: default

source:

repoURL: https://github.com/myorg/microservices-config.git

targetRevision: HEAD

path: kubernetes/overlays/dev

destination:

server: https://kubernetes.default.svc

namespace: microservices

syncPolicy:

automated:

prune: true

selfHeal: true

syncOptions:

- CreateNamespace=trueConfigMap과 etcd 연동 컨트롤러 (Go 코드 예시)

package main

import (

"context"

"log"

"time"

"go.etcd.io/etcd/client/v3"

v1 "k8s.io/api/core/v1"

"k8s.io/apimachinery/pkg/util/wait"

"k8s.io/client-go/informers"

"k8s.io/client-go/kubernetes"

"k8s.io/client-go/tools/cache"

"k8s.io/client-go/tools/clientcmd"

)

func main() {

// Kubernetes 클라이언트 설정

kubeconfig := "/etc/kubernetes/admin.conf"

config, err := clientcmd.BuildConfigFromFlags("", kubeconfig)

if err != nil {

log.Fatalf("Error building kubeconfig: %s", err.Error())

}

clientset, err := kubernetes.NewForConfig(config)

if err != nil {

log.Fatalf("Error creating Kubernetes client: %s", err.Error())

}

// etcd 클라이언트 설정

etcdClient, err := clientv3.New(clientv3.Config{

Endpoints: []string{"localhost:2379"},

DialTimeout: 5 * time.Second,

})

if err != nil {

log.Fatalf("Error creating etcd client: %s", err.Error())

}

defer etcdClient.Close()

// ConfigMap 감시 설정

factory := informers.NewSharedInformerFactory(clientset, 30*time.Second)

informer := factory.Core().V1().ConfigMaps().Informer()

// ConfigMap 이벤트 핸들러

informer.AddEventHandler(cache.ResourceEventHandlerFuncs{

AddFunc: func(obj interface{}) {

configMap := obj.(*v1.ConfigMap)

if configMap.Labels["sync-to-etcd"] == "true" {

syncConfigMapToEtcd(etcdClient, configMap)

}

},

UpdateFunc: func(old, new interface{}) {

configMap := new.(*v1.ConfigMap)

if configMap.Labels["sync-to-etcd"] == "true" {

syncConfigMapToEtcd(etcdClient, configMap)

}

},

})

// 인포머 시작

stop := make(chan struct{})

defer close(stop)

factory.Start(stop)

if !cache.WaitForCacheSync(stop, informer.HasSynced) {

log.Fatal("Timed out waiting for caches to sync")

}

// 무한 실행

wait.Forever(func() {}, 1*time.Second)

}

// ConfigMap을 etcd로 동기화

func syncConfigMapToEtcd(client *clientv3.Client, configMap *v1.ConfigMap) {

baseKey := "/config/" + configMap.Namespace + "/" + configMap.Name + "/"

ctx, cancel := context.WithTimeout(context.Background(), 5*time.Second)

defer cancel()

// 기존 키 정리 (선택적)

_, err := client.Delete(ctx, baseKey, clientv3.WithPrefix())

if err != nil {

log.Printf("Error cleaning etcd keys: %s", err.Error())

}

// ConfigMap 데이터를 etcd에 저장

for k, v := range configMap.Data {

_, err := client.Put(ctx, baseKey+k, v)

if err != nil {

log.Printf("Error syncing key %s to etcd: %s", k, err.Error())

} else {

log.Printf("Synced key %s to etcd", k)

}

}

}형상 관리의 모범 사례

- 환경별 설정 분리

- Kustomize 오버레이 또는 Helm 값 파일로 환경별 설정 분리

- 공통 설정과 환경별 설정 계층화

- 비밀 관리

- HashiCorp Vault, AWS Secrets Manager 같은 전용 비밀 관리 도구 활용

- Sealed Secrets 또는 External Secrets Operator를 통한 비밀 관리

- Git에 절대 평문 비밀 저장 금지

- 변경 승인 워크플로우

- PR(Pull Request) 기반 변경 관리

- 자동화된 검증과 테스트

- 2인 승인 원칙

- 설정 검증 자동화

- 정적 분석: yamllint, kubeval 등

- 보안 스캔: kubesec, trivy 등

- 정책 검증: Open Policy Agent(OPA)

- 감사 및 컴플라이언스

- 모든 변경 이력 추적

- 승인 과정 문서화

- 정기적인 보안 감사

통합 아키텍처: etcd, Tilt, GitOps를 결합한 접근법

개발-테스트-운영 환경 연계 아키텍처

아래는 개발부터 운영까지 효과적인 설정 관리를 위한 통합 아키텍처 예시입니다.

- 개발 환경 (Tilt + Local etcd)

- 로컬 Kubernetes(minikube, kind, k3d)

- Tilt를 통한 개발 자동화

- 로컬 etcd로 설정 관리

- 개발자 별 독립 환경

- 테스트 환경 (GitOps + Shared etcd)

- ArgoCD/Flux를 통한 배포 자동화

- 공유 etcd 클러스터

- 설정 변경 이력 추적

- 통합 테스트 환경

- 운영 환경 (GitOps + HA etcd)

- 고가용성 etcd 클러스터

- 엄격한 변경 승인 절차

- 보안 강화 설정

- 롤백 메커니즘

설정 승격 워크플로우

개발에서 운영으로의 설정 승격 과정

- 개발 설정 작성: 개발자가 로컬 Tilt 환경에서 설정 개발

- Git 커밋 및 PR: 설정 변경을 Git에 커밋하고 PR 생성

- 자동 검증 및 테스트: CI/CD 파이프라인에서 설정 검증 및 테스트

- 코드 리뷰 및 승인: 다른 개발자/운영자의 변경 검토 및 승인

- 테스트 환경 배포: GitOps 컨트롤러가 테스트 환경에 자동 배포

- 통합 테스트: 새 설정의 통합 테스트 수행

- 운영 승격 승인: 운영 환경 배포 승인

- 운영 환경 배포: GitOps 컨트롤러가 운영 환경에 자동 배포

- 모니터링 및 검증: 배포 후 시스템 정상 작동 확인

통합 도구 구성 예시

개발 환경

# 로컬 개발 환경 설정 스크립트

#!/bin/bash

# 로컬 Kubernetes 클러스터 시작

kind create cluster --name dev

# etcd 배포

kubectl apply -f kubernetes/etcd.yaml

# 초기 설정 로드

./scripts/init-etcd-config.sh

# Tilt 시작

tilt upGitOps 설정 (ArgoCD)

# argocd/applications/microservices.yaml

apiVersion: argoproj.io/v1alpha1

kind: ApplicationSet

metadata:

name: microservices

namespace: argocd

spec:

generators:

- list:

elements:

- name: dev

cluster: dev

url: https://kubernetes.dev.example.com

- name: staging

cluster: staging

url: https://kubernetes.staging.example.com

- name: prod

cluster: prod

url: https://kubernetes.prod.example.com

template:

metadata:

name: '{{name}}-microservices'

spec:

project: default

source:

repoURL: https://github.com/myorg/microservices-config.git

targetRevision: HEAD

path: kubernetes/overlays/{{name}}

destination:

server: '{{url}}'

namespace: microservices

syncPolicy:

automated:

prune: true

selfHeal: true

syncOptions:

- CreateNamespace=true통합 환경 설정 검증 CI 파이프라인 (GitHub Actions)

# .github/workflows/validate-config.yaml

name: Validate Configuration

on:

pull_request:

paths:

- 'kubernetes/**'

- 'config/**'

jobs:

validate:

runs-on: ubuntu-latest

steps:

- uses: actions/checkout@v2

- name: YAML Lint

run: |

pip install yamllint

yamllint kubernetes/ config/

- name: Kubernetes Validation

run: |

curl -L https://github.com/instrumenta/kubeval/releases/latest/download/kubeval-linux-amd64.tar.gz | tar xz

./kubeval --strict kubernetes/**/*.yaml

- name: Security Scan

run: |

curl -sfL https://raw.githubusercontent.com/aquasecurity/trivy/main/contrib/install.sh | sh -s -- -b /usr/local/bin

trivy config kubernetes/

- name: Policy Check

run: |

curl -L https://github.com/open-policy-agent/conftest/releases/download/v0.30.0/conftest_0.30.0_Linux_x86_64.tar.gz | tar xz

./conftest test kubernetes/ -p policies/실전 적용 가이드

리눅스 환경의 효과적인 설정 관리

Windows 레지스트리와 유사한 중앙화된 설정 관리를 리눅스 환경, 특히 컨테이너 및 Kubernetes 환경에서 구현하기 위해 다음과 같은 접근법을 조합하는 것이 효과적입니다.

- etcd를 중앙 저장소로 활용: 분산 환경의 신뢰할 수 있는 설정 저장소

- Tilt로 개발 자동화: 로컬 개발 환경의 효율성과 일관성 확보

- GitOps로 형상 관리: 선언적이고 감사 가능한 설정 관리

- 환경별 분리와 승격 과정 자동화: 개발에서 운영까지 체계적 관리

이러한 통합 접근법은 다음과 같은 이점을 제공합니다.

- 일관성: 모든 환경에서 동일한 설정 관리 방식

- 자동화: 변경 감지 및 적용 자동화

- 가시성: 설정 변경 이력 및 현재 상태 추적

- 보안: 적절한 접근 제어 및 비밀 관리

- 확장성: 다수의 서비스와 환경으로 확장 가능

실전 적용 단계별 가이드

시스템 환경 정보 관리를 위한 단계별 접근법

- 현황 평가 및 계획

- 현재 설정 관리 방식 검토

- 필요한 도구 및 인프라 결정

- 마이그레이션 계획 수립

- 기본 인프라 구축

- etcd 클러스터 설정 (개발/테스트/운영)

- GitOps 도구 설치 (ArgoCD/Flux)

- CI/CD 파이프라인 구성

- 개발 환경 최적화

- Tilt 도입

- 로컬 개발 워크플로우 표준화

- 설정 검증 자동화

- 설정 구조 설계

- 계층적 키 구조 정의

- 환경별 분리 전략

- 변경 승인 워크플로우 구축

- 운영 환경 구성 및 보안 강화

- HA etcd 클러스터 구성

- TLS 및 인증 설정

- 접근 제어 및 감사 체계 구축

- 모니터링 및 장애 대응 체계

- etcd 모니터링 구성

- 백업 및 복구 절차 수립

- 장애 시나리오 훈련

클라우드 네이티브 환경에서의 설정 관리

현대적인 클라우드 네이티브 환경에서 설정 관리의 발전 방향

- 서비스 메시 통합

- Istio, Linkerd 등 서비스 메시와의 통합

- 설정 변경의 점진적 롤아웃과 카나리 배포

- 머신러닝 기반 설정 최적화

- 자동 설정 조정 및 최적화

- 설정 이상 탐지 및 예방

- 멀티클라우드 설정 통합

- 클라우드 간 일관된 설정 관리

- 하이브리드 환경에서의 통합 관리

- 제로트러스트 보안 모델

- 컨텍스트 기반 설정 접근 제어

- 세분화된 권한 관리

효과적인 시스템 환경 관리는 단순한 도구 선택을 넘어, 조직의 개발 문화와 운영 철학과 밀접하게 연결됩니다. etcd와 Tilt와 같은 도구는 기술적 솔루션을 제공하지만, 최종적으로는 이를 효과적으로 활용하기 위한 프로세스와 사람이 중요합니다.

댓글