Apache Airflow를 통한 데이터 파이프라인 관리는 고도의 기술적 이해와 운영 노하우를 요구합니다. 실제 운영 과정에서 발견되는 다양한 문제들에 대한 체계적이고 실용적인 대응 방안은 시스템의 안정성을 보장하고, 효율적인 운영을 가능하게 합니다. 아래는 Airflow 운영을 고도화하고, 주요 문제에 대응하는 방안에 대한 종합적인 유형입니다.

Airflow 운영 고도화 및 문제 대응 전략

1. 리소스 관리 최적화

- 동적 리소스 할당: Airflow의 동적 리소스 할당 기능을 활용하여, 실행 중인 Task의 수와 유형에 따라 필요한 리소스를 동적으로 할당합니다. 이를 위해 KubernetesExecutor를 사용하면, 각 Task에 필요한 CPU와 메모리를 Task 정의 시 지정할 수 있습니다.

- Airflow Pool과 Deferrable 연산자 활용: 작업의 병렬 실행 수를 조절하여 리소스를 효율적으로 분배하고, 작업 대기 시간을 최소화합니다. Deferrable 연산자를 활용하면, 리소스가 부족할 때 작업을 일시적으로 지연시키고, 리소스가 확보되면 자동으로 재개됩니다.

2. 에러 관리 및 로깅

- 로깅 전략 수립: 로그 수준을 상세하게 설정하여, 문제 발생 시 신속한 진단이 가능하도록 합니다. Airflow는 로그를 원격 저장소에 저장하도록 설정할 수 있으며, 이는 문제 해결과정에서 중요한 정보를 제공합니다.

- 에러 알림 시스템 구축: Airflow의 EmailOperator, SlackOperator 등을 활용하여, 실패한 Task에 대한 알림을 구성팀원에게 즉시 전송합니다. 이를 통해 문제에 빠르게 대응할 수 있습니다.

3. 성능 최적화

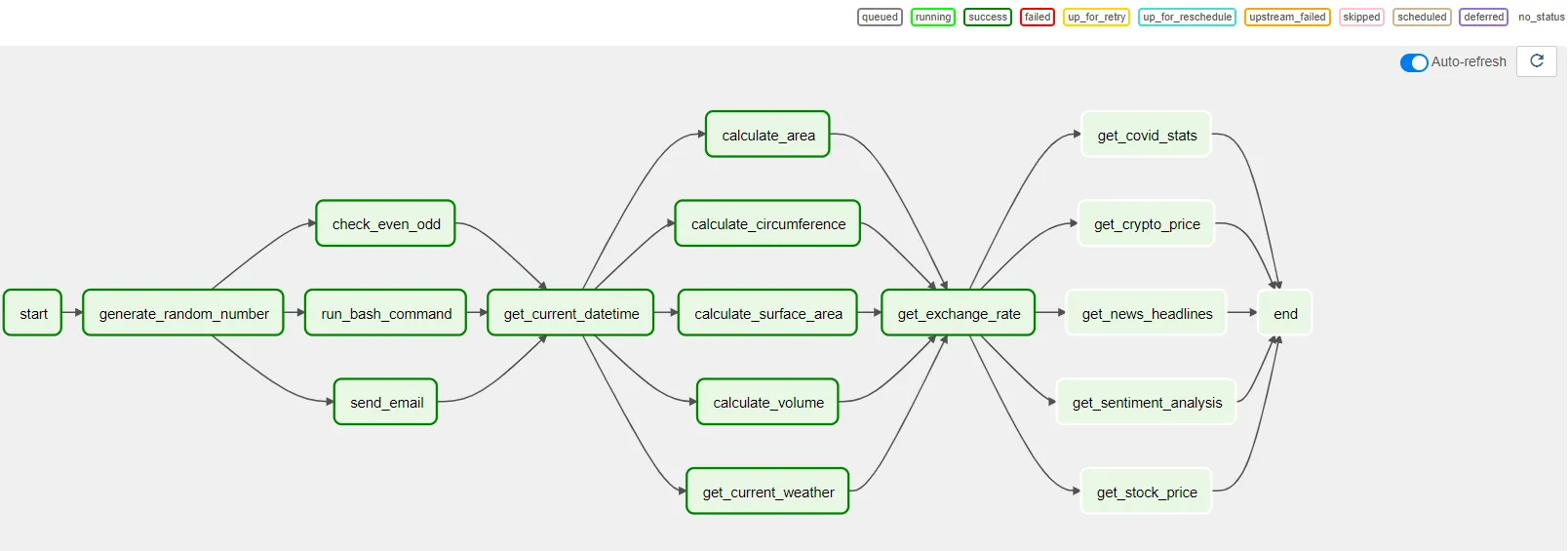

- DAG 최적화: Airflow DAG의 구조를 최적화하여, 의존성이 최소화되고 병렬 실행이 최대화되도록 합니다. 이는 전체 워크플로우의 실행 시간을 단축시키는 핵심 요소입니다.

- Scheduler 성능 조정: Airflow의

airflow.cfg파일에서 Scheduler의 성능 관련 설정을 조정하여, 작업 스케줄링의 효율성을 높입니다. 예를 들어,scheduler_heartbeat_sec,dag_dir_list_interval,min_file_process_interval등의 값을 조정하여 Scheduler의 반응 속도와 DAG 파싱 주기를 최적화합니다.

4. 고급 에러 대응 전략

- 비정상 노드 대응: Kubernetes에서 실행되는 Airflow 환경에서는, 노드의 상태를 모니터링하고, 비정상 노드를 자동으로 격리하거나 교체하는 자동화된 메커니즘을 구현합니다. 이를 위해 Kubernetes의 자체 헬스 체크와 자동 복구 기능을 적극 활용합니다.

- Queue 무한 대기 현상 해결: CeleryExecutor 또는 KubernetesExecutor를 사용하는 경우, Task가 예상치 않게 큐에 무한히 대기하는 문제에 대응하기 위해, Airflow의 내부 로직을 활용하여 대기 중인 Task를 자동으로 감지하고 재시도하도록 설정합니다.

5. 사용자 경험 향상

- 웹 인터페이스 커스터마이징: Airflow의 웹 UI를 커스터마이징하여 사용자의 편의성을 향상시킵니다. 예를 들어, DAG의 실행 상태를 더 직관적으로 표시하거나, 자주 사용하는 기능에 대한 바로 가기를 추가합니다.

- 웹 서버 재기동 시간 단축: DAG Serialization 기능을 활용하여 웹 서버의 재기동 시간을 단축시킵니다. 또한, 웹 서버와 Scheduler의 분리 배포를 통해, 웹 서버의 재기동이 Scheduler의 성능에 영향을 미치지 않도록 합니다.

Apache Airflow 운영의 성공은 세심한 계획, 체계적인 리소스 관리, 그리고 예기치 않은 문제에 대한 신속한 대응 능력에 달려 있습니다. 위에서 제시한 고도화 전략과 문제 대응 방안을 통해, 데이터 파이프라인의 안정성을 보장하고, 운영 효율성을 극대화할 수 있습니다.

Apache Airflow는 워크플로우 관리 플랫폼으로, 데이터 엔지니어링 및 ETL 작업에 널리 사용됩니다. Airflow Directed Acyclic Graphs (DAGs)는 작업의 실행 순서와 의존성을 정의합니다. GitLab은 소스 코드 관리, CI/CD (지속적 통합 및 지속적 배포), 이슈 추적 등 다양한 개발 관련 기능을 제공하는 플랫폼입니다. Airflow DAG를 GitLab 소스 저장소와 연계하여 배포 관리 및 CI/CD를 통해 효과적으로 운영하는 방법에 대해 알아보겠습니다.

GitLab에 Airflow DAG 저장소 설정하기

- GitLab 프로젝트 생성: Airflow DAG들을 저장할 GitLab 프로젝트를 생성합니다. 이 프로젝트는 DAG 코드, 관련 스크립트, 환경 설정 파일 등을 포함합니다.

- 저장소 클론: 생성된 GitLab 프로젝트의 저장소를 Airflow가 설치된 서버 또는 개발 환경에 클론합니다.

Airflow와 GitLab CI/CD 통합

- CI/CD 파이프라인 구성:

.gitlab-ci.yml파일을 프로젝트 루트에 생성하여 GitLab CI/CD 파이프라인을 구성합니다. 이 파일은 코드 변경이 push되거나 merge request가 생성될 때 실행될 작업을 정의합니다. - 예를 들어, 코드 품질 검사, 단위 테스트 실행, DAG 유효성 검사 등의 작업을 자동화할 수 있습니다.

- DAG 유효성 검사: CI 파이프라인의 일환으로, 변경된 DAG 파일의 유효성을 검사하는 스텝을 추가합니다. Airflow CLI 명령어

airflow dags validate를 사용하여 DAG 파일이 올바른지 검사할 수 있습니다. - 자동 배포 설정: CI/CD 파이프라인에 DAG 파일을 Airflow가 설치된 서버로 자동 배포하는 스텝을 추가합니다. 이를 위해 SSH, SCP, 또는 Kubernetes를 통한 Helm 차트 업데이트 등의 방법을 사용할 수 있습니다.

보안과 환경 관리

- 비밀 관리: Airflow와 관련된 비밀번호, API 키 등의 민감한 정보는 GitLab의 CI/CD 비밀 변수 기능을 사용하여 안전하게 관리합니다. 이러한 변수들은 파이프라인에서 사용할 수 있으나, 저장소의 코드에는 노출되지 않습니다.

- 환경별 설정: 개발, 스테이징, 프로덕션 등 다양한 환경을 위한 설정을 구분하여 관리할 수 있습니다. GitLab의 환경(environment) 기능을 활용하여 각 환경에 맞는 CI/CD 파이프라인을 설정할 수 있습니다.

GitLab에서의 코드 리뷰와 협업

- Merge Requests: DAG 코드 변경 사항에 대해 Merge Request를 생성하여 코드 리뷰를 진행합니다. 이는 코드 품질을 유지하고 팀 내 협업을 촉진합니다.

- 이슈 추적: GitLab의 이슈 추적 기능을 사용하여 DAG 개발 및 유지 보수와 관련된 작업을 관리합니다.

GitLab과 Airflow를 통합하여 사용하면, DAG 코드의 버전 관리, 코드 리뷰, 자동 테스트 및 배포 등의 프로세스를 효율적으로 관리할 수 있습니다. 이를 통해 데이터 엔지니어링 팀은 보다 신속하고 안정적으로 데이터 파이프라인을 개발 및 운영할 수 있습니다. CI/CD 파이프라인의 자동화는 오류를 줄이고, 배포 속도를 높이며, 전반적인 개발 생산성을 향상시키는 중요한 요소입니다.

Airflow DAGs를 GitLab을 이용해 CI/CD 파이프라인으로 관리하는 방법에 대한 구체적인 예시로, 아래 예시에서는 GitLab의 .gitlab-ci.yml 파일을 설정하여 DAG 파일의 유효성 검사, 자동 테스트 실행, 그리고 변경 사항이 master 브랜치에 병합될 때 자동으로 배포하는 과정을 다룹니다.

1. GitLab CI/CD 파이프라인 설정 (.gitlab-ci.yml)

GitLab 프로젝트의 루트 디렉토리에 .gitlab-ci.yml 파일을 생성하고 다음과 같이 구성합니다.

stages:

- validate

- test

- deploy

variables:

AIRFLOW_DAGS_FOLDER: "/path/to/your/airflow/dags"

validate_dags:

stage: validate

image: apache/airflow:2.1.0

script:

- airflow dags validate

unit_tests:

stage: test

image: python:3.8-slim

script:

- pip install -r requirements.txt

- python -m unittest discover -s tests

deploy_to_airflow:

stage: deploy

only:

- master

script:

- scp -r $AIRFLOW_DAGS_FOLDER user@your_airflow_server:/path/to/airflow/dags

environment:

name: production- Stages: CI/CD 파이프라인은

validate,test,deploy세 단계로 구성됩니다.validate단계에서는 Airflow의dags validate명령어를 사용하여 모든 DAG 파일의 유효성을 검사합니다.test단계에서는 Python 환경에서 필요한 패키지를 설치한 후, DAG 관련 단위 테스트를 실행합니다.deploy단계는master브랜치에 변경 사항이 병합될 때만 실행되며, 변경된 DAG 파일을 Airflow 서버의 DAGs 폴더로 복사합니다.

- Variables:

AIRFLOW_DAGS_FOLDER는 로컬에서 Airflow DAGs 폴더의 경로를 나타냅니다. 이는 배포 스크립트에서 사용됩니다. - validate_dags Job: Apache Airflow Docker 이미지를 사용하여 DAG 파일의 유효성을 검증합니다.

- unit_tests Job: 필요한 Python 패키지를 설치한 후,

unittest모듈을 사용해 단위 테스트를 실행합니다. - deploy_to_airflow Job: SCP (Secure Copy Protocol)를 사용하여 변경된 DAG 파일을 Airflow 서버로 복사합니다. 이 작업은

master브랜치에 대해서만 실행됩니다.

추가 사항

- 비밀 관리:

user@your_airflow_server와 같이 사용하는 서버 주소 및 사용자 이름, SSH 키 등은 GitLab의 CI/CD 비밀 변수 기능을 통해 안전하게 관리해야 합니다. 이렇게 하면 코드 내에 직접적으로 민감한 정보를 노출하지 않고 사용할 수 있습니다. - 환경별 설정:

environment설정을 통해 배포 대상 환경을 명시할 수 있습니다. 이 예제에서는production환경으로 설정되어 있지만, 필요에 따라 여러 환경(예:development,staging)에 대해 다른 설정을 적용할 수 있습니다.

위 예시는 Airflow DAGs를 GitLab CI/CD 파이프라인을 통해 효율적으로 관리하기 위한 기본적인 구성을 보여줍니다. 실제 환경에서는 프로젝트의 요구 사항과 인프라에 맞게 조정하고 추가적인 단계나 검증 과정을 포함할 수 있습니다.

댓글