OpenAI에서 지원을 시작한 Model Context Protocol(MCP)에 대해서 개념부터 실질적인 활용 방안입니다.

MCP 개념 이해

Model Context Protocol(MCP) 은 인공지능(LLM)이 외부 데이터 및 도구와 상호작용하기 위한 개방형 표준 프로토콜입니다. 쉽게 표현하면,

- USB-C 포트가 다양한 장치를 표준 방식으로 연결하는 것처럼, MCP는 AI 모델과 다양한 데이터 소스 및 도구를 표준화된 방식으로 연결합니다.

- LLM이 특정 도구(파일시스템, DB, 외부 API 등)를 호출하고 활용할 수 있도록 지원합니다.

즉, MCP 서버라는 형태로 외부 도구나 데이터를 표준 인터페이스로 제공하고, 이를 LLM이 쉽게 호출할 수 있게 됩니다.

MCP 서버의 종류

MCP 서버는 현재 두 가지 방식으로 지원됩니다.

| 서버 종류 | 특징 | 예시 |

|---|---|---|

| stdio 서버 | 로컬 환경에서 별도 프로세스로 실행(서브 프로세스) | 로컬 파일 시스템 접근 |

| HTTP(SSE 방식) 서버 | 원격에서 실행되고 HTTP URL을 통해 접근 | 원격 API, DB 연동 등 |

- 로컬 환경의 도구는 stdio로 빠르게 실행되고, 외부 원격 시스템이나 API는 HTTP(SSE) 방식으로 접근하는 것이 일반적입니다.

MCP 서버 활용 방법 (OpenAI Agents SDK)

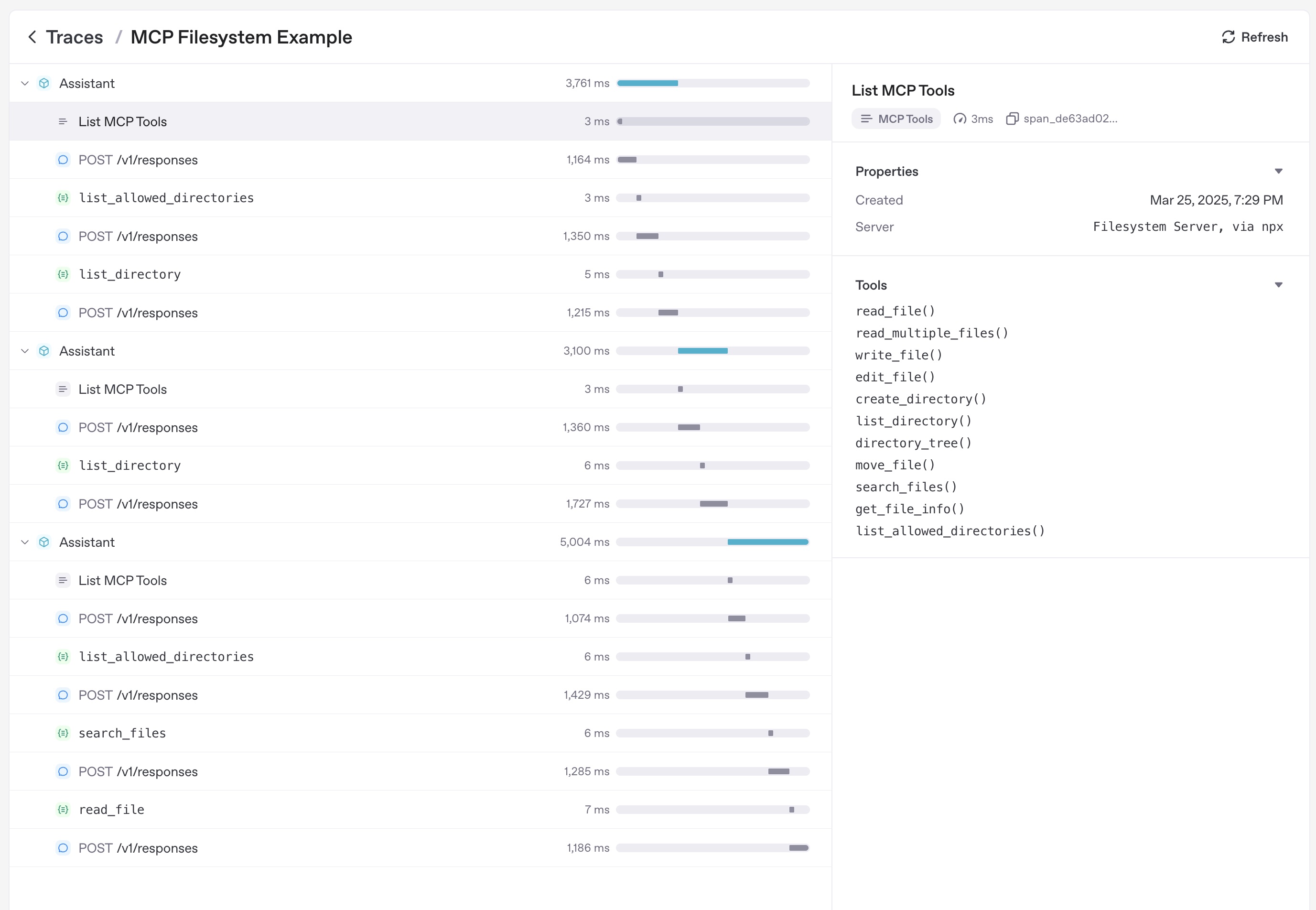

OpenAI에서 제공하는 Agents SDK를 활용하여 MCP 서버를 연결하고 LLM과 연계하는 방법은 다음과 같습니다.

(1) MCP 서버 연결 (Filesystem 서버 예시)

예시로 로컬의 파일 시스템에 접근할 수 있는 MCP 서버를 연결하는 방법입니다.

Python 코드 예시

from openai import MCPServerStdio

# MCP 서버 연결 (로컬 파일 시스템 서버 예시)

async with MCPServerStdio(

params={

"command": "npx",

"args": ["-y", "@modelcontextprotocol/server-filesystem", "/path/to/files"],

}

) as server:

tools = await server.list_tools()

print("제공되는 도구 목록:", tools)- 위의 예시는 MCP 공식 파일 시스템 서버를 통해 특정 디렉터리의 파일들을 LLM에게 노출할 수 있습니다.

(2) Agent와 MCP 서버 연결 및 활용

실제 OpenAI의 Agent와 MCP 서버를 연계하여 사용하는 방법입니다.

Agent 초기화 코드 예시

from openai import Agent, MCPServerStdio

# MCP 서버 초기화

mcp_server_fs = MCPServerStdio(

params={

"command": "npx",

"args": ["-y", "@modelcontextprotocol/server-filesystem", "/path/to/files"],

}

)

# Agent 생성 시 MCP 서버 연결

agent = Agent(

name="AI Assistant",

instructions="제공된 도구를 활용하여 업무를 수행하세요.",

mcp_servers=[mcp_server_fs]

)

# Agent 실행 시 LLM이 MCP 서버의 도구를 자동으로 호출 가능

response = agent.run("최근 수정된 파일 목록을 보여주세요.")

print(response)- Agent는 MCP 서버로부터

list_tools()호출을 통해 사용 가능한 도구 목록을 받아옵니다. - LLM이 특정 도구 호출을 결정하면, 자동으로 MCP 서버의

call_tool()을 실행하여 결과를 반환받습니다.

MCP 서버 도구 목록 캐싱(Caching)

매번 Agent가 실행될 때마다 MCP 서버의 list_tools()을 호출하면 네트워크나 I/O 지연이 발생할 수 있습니다. 이를 방지하기 위해 MCP 서버 연결 시 도구 목록 캐싱을 설정할 수 있습니다.

캐싱 설정 예시

# 도구 목록 캐싱 활성화

mcp_server_fs = MCPServerStdio(

params={

"command": "npx",

"args": ["-y", "@modelcontextprotocol/server-filesystem", "/path/to/files"],

},

cache_tools_list=True # 도구 목록을 캐싱하여 성능 향상

)- 도구 목록이 변경되지 않는 환경에서만 캐싱을 활성화하는 것이 좋습니다.

- 캐시를 무효화하려면

invalidate_tools_cache()호출하면 됩니다.

실질적인 활용 사례

MCP 서버를 실제 비즈니스 환경에서 활용할 수 있는 사례입니다.

| 활용 분야 | MCP 서버 예시 | 활용 시나리오 |

|---|---|---|

| 파일 관리 | Filesystem 서버 | LLM이 로컬 디스크의 파일 관리 및 문서 검색 |

| 데이터베이스 연동 | MySQL, MongoDB MCP 서버 | DB 데이터 조회, 분석 및 실시간 반영 |

| 코드 관리(GitHub 등) | GitHub MCP 서버 | GitHub의 풀 리퀘스트(PR) 생성, 코드 리뷰 자동화 |

| 외부 API 자동화 | API Gateway MCP 서버 | API 호출 자동화, API 변경사항 즉시 반영 |

| 보안/인프라 자동화 | OSQuery, Wazuh MCP 서버 | 보안 취약점 실시간 점검, 자동 보고서 생성 |

MCP 서버 보안 점검 사항

기업 환경에서 MCP 서버를 운영할 때 반드시 점검하고 적용해야 하는 보안 포인트는 다음과 같습니다.

- 인증 및 접근통제

MCP 서버 및 도구 접근 권한 최소화, RBAC(Role-based Access Control) 적용 필수 - 통신 보안

HTTP 방식 MCP 서버 사용 시 TLS(HTTPS) 적용 필수 - 도구 목록 접근 제한

민감한 데이터나 도구 목록은 인가된 사용자나 LLM에게만 제공 - 로깅 및 감사

MCP 서버의 도구 호출 내역, API 요청 내역, 인증 및 권한 변경 이력 로깅 - 취약점 점검

MCP 서버의 코드나 연동 환경에 대한 주기적 보안 점검, 코드 리뷰 및 보안 패치 적용

OpenAI의 MCP 지원을 통해 AI 모델이 다양한 외부 도구와 쉽게 연계될 수 있습니다. 이를 통해 API 자동화, 파일 관리 자동화, 보안 점검 자동화 등 다양한 영역에서 실질적인 업무 효율성 증대를 이룰 수 있습니다.

- 초기에는 로컬(stdio) MCP 서버로 테스트 후, 이후 HTTP 서버로 확장 권장

- OpenAPI 등 기존 API 관리 체계와 MCP 서버를 연결하여 더욱 강력한 자동화를 구축 권장

- 보안 가이드 반드시 병행하여 운영 필수

위의 사항을 기반으로 MCP 서버를 운영하면, AI 기반 자동화를 실무에서 매우 효과적으로 활용할 수 있습니다.

AI 개발 혁신! Claude와 Cursor, MCP를 활용한 자동화 시스템 구축

Claude 3.5 Sonnet은 Anthropic이 개발한 고급 AI 언어 모델로, 이전 버전에서 크게 향상된 다양한 기능을 제공합니다.1. 비전(Vision) 기능 향상Claude 3.5 Sonnet은 이미지 내의 차트와 그래프를 해석하는 시각

blog.pages.kr

API Gateway로 MCP와 연계한 양방향 생성형 AI 프롬프트 (AI Agent) 활용

Agentic AI(에이전틱 AI), Generative AI(생성형 AI), Model Context Protocol(MCP)는 모두 최신 AI 기술과 관련된 개념이지만, 각각의 목적과 특성이 다릅니다. 각 개념에 대한 기본 정의와 특성, 차이점, 활용 사

blog.pages.kr

댓글