InfluxDB는 고성능 시계열 데이터베이스로서, 시계열 데이터를 저장, 조회 및 분석하기 위한 오픈 소스 데이터베이스 시스템입니다. 주로 모니터링, 성능 분석, IoT(사물 인터넷) 및 이벤트 로깅과 같은 애플리케이션에서 사용됩니다. 시계열 데이터는 시간 순서대로 정렬된 데이터 포인트의 스트림으로 이해할 수 있으며, 예를 들어 센서 데이터, 서버 로그, 성능 메트릭 등을 포함합니다.

InfluxDB의 주요 특징은 다음과 같습니다.

- 높은 성능: 시계열 데이터에 최적화되어 빠른 쿼리 처리 및 데이터 저장이 가능합니다.

- SQL 라이크 쿼리 언어: InfluxQL이라고 하는 SQL과 유사한 쿼리 언어를 제공합니다.

- 데이터 유지 보수 정책: 데이터 보존 정책을 정의하여 데이터 보관 기간을 자동으로 관리할 수 있습니다.

- 태그 및 필드: 데이터를 태그와 필드로 구분하여 유연한 데이터 모델링을 제공합니다.

- 확장성: 클러스터링을 지원하여 데이터베이스를 수평 확장할 수 있습니다.

InfluxDB를 Docker 환경에서 구성하는 방법은 다음과 같습니다.

단계 1: Docker 설치

Docker를 설치하고 구성합니다. Docker는 다양한 플랫폼에서 사용할 수 있으며, 설치 지침은 공식 Docker 웹 사이트에서 찾을 수 있습니다.

단계 2: InfluxDB Docker 이미지 다운로드

InfluxDB를 Docker 이미지로 다운로드하려면 다음 명령을 사용합니다.

docker pull influxdb

단계 3: InfluxDB 컨테이너 생성

다음 명령을 사용하여 InfluxDB 컨테이너를 생성합니다. 이때 -p 옵션을 사용하여 호스트와 컨테이너 간의 포트 매핑을 설정합니다.

docker run -d -p 8086:8086 --name influxdb -e INFLUXDB_DB=mydb influxdb여기서 -e INFLUXDB_DB=mydb는 InfluxDB에 데이터베이스 "mydb"를 만드는 환경 변수를 설정하는 예시입니다. 필요에 따라 데이터베이스 이름을 변경할 수 있습니다.

단계 4: InfluxDB 관리 및 접속

InfluxDB 관리자 인터페이스에 액세스하려면 웹 브라우저에서 http://localhost:8086로 접속하거나 InfluxDB CLI를 사용할 수 있습니다.

InfluxDB CLI에 접속하려면 다음 명령을 사용합니다.

docker exec -it influxdb influx이제 InfluxDB를 Docker 환경에서 실행하고 관리할 수 있습니다. 데이터를 저장하고 쿼리하기 위한 클라이언트 또는 라이브러리를 사용하여 시계열 데이터를 InfluxDB에 추가하고 검색할 수 있습니다.

네트워크 장비의 트래픽을 sFlow로 수집하고 이 데이터를 InfluxDB로 적재하는 프로세스는 몇 가지 단계로 구성됩니다. 이 프로세스는 sFlow 수집기, InfluxDB 데이터베이스, 그리고 데이터를 수집하고 InfluxDB로 전송하는 중간 소프트웨어를 포함합니다.

아래에서는 이러한 단계를 단계별로 안내하고 필요한 코드 또는 명령을 제공합니다.

단계 1: sFlow 수집기 설정

먼저 sFlow 데이터를 수집할 수 있는 sFlow 수집기를 설정해야 합니다. 이 수집기는 네트워크 장비에 연결되어 sFlow 데이터를 수집하고 전송합니다.

단계 2: sFlow 수집기에서 데이터 전송

sFlow 수집기에서 InfluxDB로 데이터를 전송할 중간 소프트웨어 또는 스크립트를 사용해야 합니다. 이 중간 소프트웨어는 sFlow 데이터를 수집하고 InfluxDB에 전송하는 역할을 합니다.

이러한 중간 소프트웨어를 개발하려면 Python, Node.js, 또는 다른 언어를 사용하여 sFlow 데이터를 수집하고 InfluxDB로 전송하는 코드를 작성해야 합니다.

아래는 Python을 사용한 간단한 예제 코드입니다.

import socket

from influxdb import InfluxDBClient

# InfluxDB 연결 정보

influxdb_host = 'localhost'

influxdb_port = 8086

influxdb_database = 'sflow_data'

# sFlow 수집기 정보

sflow_host = 'sflow-collector-host'

sflow_port = 6343

# InfluxDB 클라이언트 설정

client = InfluxDBClient(host=influxdb_host, port=influxdb_port)

client.switch_database(influxdb_database)

# sFlow 데이터 수신 및 InfluxDB로 전송

with socket.socket(socket.AF_INET, socket.SOCK_DGRAM) as sflow_socket:

sflow_socket.bind((sflow_host, sflow_port))

while True:

data, addr = sflow_socket.recvfrom(65536)

# sFlow 데이터 처리 및 InfluxDB로 전송하는 코드 작성

# 예시: InfluxDB로 데이터 포인트 전송

json_body = [

{

"measurement": "network_traffic",

"tags": {

"source": "sflow_collector"

},

"time": "timestamp",

"fields": {

"data_field": "data_value"

}

}

]

client.write_points(json_body)이 코드는 sFlow 데이터를 수신하고 필요에 따라 데이터를 처리한 다음 InfluxDB로 전송합니다. 실제 데이터 처리 및 InfluxDB 스키마는 프로젝트 요구사항에 따라 다를 수 있습니다.

단계 3: InfluxDB 설정 및 데이터베이스 생성

InfluxDB를 설치하고 설정한 후 데이터를 저장할 데이터베이스를 생성해야 합니다. 이를 위해 InfluxDB CLI 또는 HTTP API를 사용할 수 있습니다.

아래는 InfluxDB CLI를 사용한 예시입니다.

# InfluxDB CLI에 접속

influx

# 데이터베이스 생성

CREATE DATABASE sflow_data

# 데이터베이스 확인

SHOW DATABASES

단계 4: 데이터 수집 및 저장

중간 소프트웨어가 sFlow 데이터를 수집하고 InfluxDB로 전송한 후, 데이터는 InfluxDB 데이터베이스에 저장됩니다.

이제 sFlow 데이터 수집과 InfluxDB 저장을 설정하고 데이터를 저장하고 조회할 수 있을 것입니다. 프로덕션 환경에서는 보안 및 확장성 고려 사항과 데이터 정리 정책을 고려해야 합니다.

Telegraf를 사용하여 sFlow 데이터를 수집하고 InfluxDB로 전송하는 것은 효과적이고 유용한 방법입니다. Telegraf는 오픈 소스 데이터 수집 및 전송 에이전트로, 다양한 데이터 소스에서 데이터를 수집하고 다양한 출력 대상으로 데이터를 전송하는 기능을 제공합니다.

아래는 Telegraf를 사용하여 sFlow 데이터를 수집하고 InfluxDB로 전송하는 방법을 단계별로 안내한 것입니다.

단계 1: Telegraf 설치

먼저 Telegraf를 설치해야 합니다. 다음 명령을 사용하여 Telegraf를 설치할 수 있습니다.

sudo apt-get update

sudo apt-get install telegraf

단계 2: Telegraf 설정

Telegraf를 구성하기 위해 설정 파일을 수정해야 합니다. Telegraf 설정 파일은 /etc/telegraf/telegraf.conf에 위치합니다. 원하는 텍스트 에디터를 사용하여 이 파일을 엽니다.

sudo nano /etc/telegraf/telegraf.confsFlow 데이터를 수집하고 InfluxDB로 전송하도록 Telegraf 구성을 추가합니다.

아래는 예시 설정 블록입니다.

[[inputs.sflow]]

agents = ["sflow-collector-host:6343"]

[[outputs.influxdb]]

urls = ["http://localhost:8086"]

database = "sflow_data"위 설정에서

[[inputs.sflow]]블록은 sFlow 데이터 수집을 구성합니다.agents필드에는 sFlow 수집기의 주소와 포트를 지정합니다.[[outputs.influxdb]]블록은 InfluxDB로 데이터를 전송하는 설정을 구성합니다.urls필드에는 InfluxDB의 주소를 지정하고,database필드에는 데이터베이스 이름을 지정합니다.

단계 3: Telegraf 서비스 시작 및 활성화

Telegraf 서비스를 시작하고 부팅 시 자동으로 시작하도록 설정합니다.

sudo systemctl start telegraf

sudo systemctl enable telegraf

단계 4: Telegraf 모니터링

Telegraf는 설정된 주기마다 sFlow 데이터를 수집하고 InfluxDB로 전송합니다. 데이터는 InfluxDB에 저장되며, 이후 InfluxDB 쿼리를 사용하여 데이터를 조회하고 시각화할 수 있습니다.

단계 5: 데이터베이스 및 쿼리 설정

InfluxDB에서 Telegraf로 전송된 데이터를 쿼리하려면 필요에 따라 데이터베이스 및 쿼리를 설정해야 합니다. 이 부분은 데이터베이스 모델링 및 데이터 분석 요구에 따라 다르므로 상세한 내용은 프로젝트에 따라 다를 수 있습니다.

Telegraf를 사용하여 sFlow 데이터를 InfluxDB로 전송하면 데이터 수집 및 관리가 훨씬 간단해집니다. 또한 Telegraf는 다양한 다른 데이터 수집 소스와 출력 대상과 통합할 수 있어 매우 확장성이 높습니다.

InfluxDB 데이터를 사용하여 Grafana 대시보드를 설정하고 네트워크 트래픽 추이 및 모니터링을 수행하는 방법입니다.

단계 1: Grafana 설치

먼저 Grafana를 설치합니다. Grafana는 다양한 운영체제에서 사용할 수 있으며, 설치 방법은 운영체제에 따라 다릅니다.

아래는 Ubuntu에서의 설치 예시입니다.

sudo apt-get update

sudo apt-get install grafana

단계 2: Grafana 서비스 시작 및 활성화

Grafana 서비스를 시작하고 부팅 시 자동으로 시작하도록 설정합니다.

sudo systemctl start grafana-server

sudo systemctl enable grafana-server

단계 3: Grafana 대시보드 설정

Grafana 웹 인터페이스에 접속합니다. 기본적으로 Grafana는 3000 포트에서 실행됩니다. 웹 브라우저를 열고 http://localhost:3000에 접속하거나 서버의 IP 주소를 사용합니다. 초기 로그인 계정은 "admin/admin"입니다.

단계 4: 데이터 소스 설정

Grafana에서 데이터를 시각화하기 위해 InfluxDB 데이터베이스를 추가해야 합니다.

- 왼쪽 메뉴에서 "Configuration" 아이콘을 클릭하고 "Data Sources"를 선택합니다.

- "Add data source" 버튼을 클릭합니다.

- "InfluxDB"를 선택하고 다음과 같이 설정합니다.

- Name: 데이터 소스에 대한 이름 (예: MyInfluxDB)

- HTTP URL: InfluxDB의 주소 (예: http://localhost:8086)

- Access: "Server"를 선택

- Database: InfluxDB에서 사용할 데이터베이스 (예: sflow_data)

- 기타 설정을 필요에 따라 구성합니다.

- "Save & Test" 버튼을 클릭하여 데이터 소스가 올바르게 연결되었는지 확인합니다.

단계 5: 대시보드 및 패널 생성

이제 대시보드를 만들고 트래픽 추이 및 모니터링을 위한 패널을 추가합니다.

- 왼쪽 메뉴에서 "Create" 아이콘을 클릭하고 "Dashboard"를 선택합니다.

- "Add new panel"을 클릭하여 새 패널을 만듭니다.

- 패널 편집 창에서 "Query" 탭을 선택합니다.

- 데이터 소스를 선택하고 InfluxDB 쿼리를 작성합니다.

예를 들어, 시간 범위에 따른 네트워크 트래픽 추이를 표시하려면 다음과 같은 쿼리를 사용할 수 있습니다.

여기서 "data_field"는 InfluxDB에 저장된 필드 이름이며, "network_traffic"은 측정치 이름입니다.SELECT mean("data_field") FROM "network_traffic" WHERE $timeFilter GROUP BY time($__interval) fill(null) - "Visualization" 탭에서 시각화 유형을 선택하고 그래프를 만듭니다. 그래프 스타일, 색상 등을 구성합니다.

- 패널을 저장하고 대시보드로 돌아갑니다.

단계 6: 대시보드 저장

대시보드에 추가한 패널을 구성하고 대시보드 상단에서 "Save" 아이콘을 클릭하고 대시보드 이름을 지정합니다.

단계 7: 대시보드 확인 및 공유

이제 대시보드에 저장한 패널을 확인하고 필요한 경우 대시보드를 공유합니다. 대시보드는 시계열 데이터를 기반으로 하는 네트워크 트래픽 추이 및 모니터링을 시각적으로 나타낼 수 있게 해줍니다.

위의 단계를 따라 하면 InfluxDB 데이터를 사용하여 Grafana 대시보드를 설정하고 트래픽 추이 및 모니터링을 수행할 수 있습니다. Grafana를 사용하면 데이터를 시각적으로 효과적으로 표시하고 모니터링할 수 있습니다.

Grafana는 시각화 및 대시보드 기능을 제공하며, 알림 관리 기능은 Prometheus 또는 InfluxDB와 같은 데이터 소스를 통합하여 사용합니다. Grafana에서 이상 트래픽을 모니터링하고 알림을 발생시키려면 다음과 같이 할 수 있습니다.

단계 1: Prometheus 또는 InfluxDB 설정

Grafana 알림을 사용하려면 먼저 Prometheus 또는 InfluxDB와 같은 데이터베이스를 설정해야 합니다. 이상 트래픽과 관련된 데이터를 수집하고 저장하는 데이터베이스를 사용해야 합니다.

단계 2: Grafana 설정

Grafana 대시보드에 대한 알림 설정을 구성합니다.

- Grafana 웹 인터페이스에 로그인하고 대시보드를 엽니다.

- "Alerting" 아이콘을 클릭하고 "Notification channels"을 선택하여 알림 채널을 설정합니다. 이 채널은 알림을 받을 방법을 정의합니다. 예를 들어, 이메일, 슬랙 봇, 웹훅, 등을 사용할 수 있습니다.

- "Notification channels" 설정을 저장하고 돌아갑니다.

- 대시보드로 돌아와서 대시보드 편집 모드로 전환합니다.

- 원하는 패널을 선택하고 패널의 "Alert" 탭을 엽니다.

- "Create Alert" 버튼을 클릭하여 알림 규칙을 생성합니다.

- 알림 규칙을 설정합니다. 이상 트래픽을 검출하기 위한 Prometheus 또는 InfluxDB 쿼리를 작성하고 해당 규칙을 설정합니다.

- "Notifications" 섹션에서 이전 단계에서 설정한 알림 채널을 선택하고 알림 메시지 등을 구성합니다.

- 알림 규칙 설정을 저장합니다.

단계 3: 알림 테스트 및 사용

알림 설정을 저장한 후, 해당 설정이 작동하는지 테스트하고 사용합니다.

- 대시보드를 저장하고 나가면 설정이 적용됩니다.

- 대시보드에서 알림이 작동하는지 확인하기 위해 이상 트래픽을 유발하는 동작을 시뮬레이션하거나 해당 조건을 만족시키는 데이터를 생성합니다.

- 알림이 작동하면 설정한 알림 채널을 통해 알림 메시지를 받게 됩니다.

- 이후, 이상 트래픽을 검출하고 알림을 통해 실시간으로 경고를 받을 수 있게 됩니다.

이러한 방법을 따라 이상 트래픽을 모니터링하고 Grafana를 사용하여 알림을 설정할 수 있습니다. 중요한 것은 알림 규칙을 정확하게 설정하여 원하는 이벤트나 조건이 발생할 때 경고를 받을 수 있도록 해야 합니다.

Grafana 자체는 이벤트를 감지하고 알림을 발생시키는 기능을 직접 제공하지 않습니다. 대신 Grafana는 다양한 데이터 소스와 통합하여 알림을 설정하고 관리할 수 있도록 하는 대시보드 및 시각화 도구입니다. 이를 위해 Prometheus, InfluxDB, 또는 기타 데이터 소스와 함께 사용하여 이상 트래픽을 모니터링하고 알림을 설정해야 합니다.

다음은 Prometheus와 Grafana를 사용하여 SMB 포트와 FTP 포트에 대한 이상 트래픽을 모니터링하고 알림을 설정하는 예시입니다.

단계 1: Prometheus 설정

- Prometheus를 설치하고 구성합니다.

- Prometheus 설정 파일 (예:

prometheus.yml)에 이상 트래픽을 모니터링할 타깃을 추가합니다. 예를 들어, SMB 포트와 FTP 포트를 모니터링하기 위해 다음과 같이 설정합니다.scrape_configs: - job_name: 'smb' static_configs: - targets: ['smb-server:445'] # Replace with your SMB server address and port - job_name: 'ftp' static_configs: - targets: ['ftp-server:21'] # Replace with your FTP server address and port - Prometheus를 시작하고 실행합니다.

단계 2: Grafana 설정

- Grafana를 설치하고 구성합니다.

- Grafana 웹 인터페이스에 로그인합니다.

단계 3: 알림 채널 설정

- Grafana의 설정에서 "Notification channels"을 선택하여 알림 채널을 설정합니다. 예를 들어, 이메일 알림을 설정할 수 있습니다.

단계 4: 알림 규칙 설정

- 대시보드에서 이상 트래픽을 모니터링하려는 패널을 만듭니다.

- 패널에서 "Alert" 탭을 선택하고 "Create Alert" 버튼을 클릭하여 새 알림 규칙을 생성합니다.

- 알림 규칙을 설정합니다. 예를 들어, 이상 트래픽을 검출하는 Prometheus 쿼리를 설정하고 알림 규칙에 액션을 추가합니다.

예:sum(rate(smb_bytes_total[1m])) > 1000 - "Notifications" 섹션에서 알림 채널을 선택하고 알림 메시지 등을 구성합니다.

- 알림 규칙 설정을 저장합니다.

단계 5: 알림 테스트 및 사용

- 알림 규칙을 저장한 후, 해당 설정이 작동하는지 확인하기 위해 이상 트래픽을 유발하는 동작을 시뮬레이션하거나 해당 조건을 만족시키는 데이터를 생성합니다.

- 알림이 작동하면 설정한 알림 채널을 통해 알림 메시지를 받게 됩니다.

앞서 설명한 것처럼, Grafana는 알림 자체를 생성하고 발송하지 않으며, Prometheus와 같은 데이터 소스를 사용하여 알림 규칙을 설정하고 이상 트래픽을 모니터링합니다. 예시에서는 이상 트래픽을 모니터링하고 Prometheus와 Grafana를 사용하여 알림을 설정하는 방법을 안내하였습니다. 실제 환경에서는 상황에 맞게 적절한 Prometheus 쿼리와 알림 규칙을 설정해야 합니다.

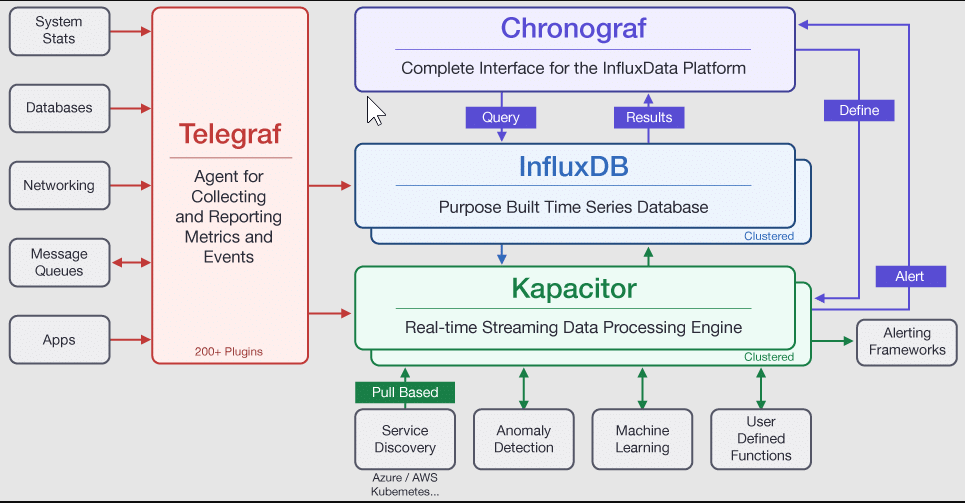

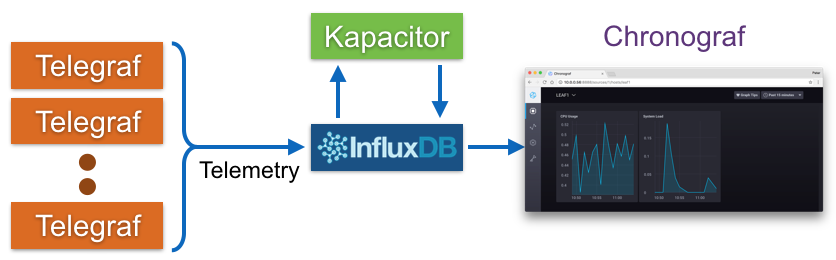

InfluxData TICK 스택 (Telegraf, InfluxDB, Chronograf, Kapacitor)을 사용하여 메트릭 데이터를 수집, 저장, 표시 및 처리하는 방법도 있습니다. TICK 스택은 Telegraf(메트릭을 내보내는 에이전트), InfluxDB(메트릭을 수집하고 저장하는 시계열 데이터베이스), Chronograf(메트릭을 표시하는 대시보드), Kapacitor(데이터 처리 엔진)의 네 가지 도구로 구성됩니다. 이러한 도구들은 오픈 소스로 제공되며 개별적으로 또는 함께 사용할 수 있습니다.

또한 데이터 센터 인프라에 포함된 표준 sFlow 에이전트를 사용하여 Telegraf 메트릭을 InfluxDB로 보내는 방법을 활용할 수 있습니다. 이 솔루션은 sFlow 메트릭을 Telegraf와 호환되는 형식으로 변환하여 sFlow-RT를 사용하여 기본 Chronograf 대시보드를 통해 즉시 확인할 수 있도록 합니다. 이를 위해 sFlow-RT를 프록시로 사용하여 sFlow 메트릭을 Telegraf 메트릭으로 변환합니다.

아래는 Telegraf 메트릭을 InfluxDB로 주기적으로 보내기 위한 telegraf.js 스크립트의 내용입니다.

var influxdb = "http://10.0.0.56:8086/write?db=telegraf";

function sendToInfluxDB(msg) {

if (!msg || !msg.length) return;

var req = {

url: influxdb,

operation: 'POST',

headers: { "Content-Type": "text/plain" },

body: msg.join('\n')

};

req.error = function (e) {

logWarning('InfluxDB POST failed, error=' + e);

}

try { httpAsync(req); }

catch (e) {

logWarning('bad request ' + req.url + ' ' + e);

}

}

var metric_names = [

'host_name',

'load_one',

'load_five',

'load_fifteen',

'cpu_num',

'uptime',

'cpu_user',

'cpu_system',

'cpu_idle',

'cpu_nice',

'cpu_wio',

'cpu_intr',

'cpu_sintr',

'cpu_steal',

'cpu_guest',

'cpu_guest_nice'

];

var ntoi;

function mVal(row, name) {

if (!ntoi) {

ntoi = {};

for (var i = 0; i < metric_names.length; i++) {

ntoi[metric_names[i]] = i;

}

}

return row[ntoi[name]].metricValue;

}

setIntervalHandler(function () {

var i, r, msg = [];

var vals = table('ALL', metric_names);

for (i = 0; i < vals.length; i++) {

r = vals[i];

// Telegraf System plugin metrics

msg.push('system,host='

+ mVal(r, 'host_name')

+ ' load1=' + mVal(r, 'load_one')

+ ',load5=' + mVal(r, 'load_five')

+ ',load15=' + mVal(r, 'load_fifteen')

+ ',n_cpus=' + mVal(r, 'cpu_num') + 'i');

msg.push('system,host='

+ mVal(r, 'host_name')

+ ' uptime=' + mVal(r, 'uptime') + 'i');

// Telegraf CPU plugin metrics

msg.push('cpu,cpu=cpu-total,host='

+ mVal(r, 'host_name')

+ ' usage_user=' + (mVal(r, 'cpu_user') || 0)

+ ',usage_system=' + (mVal(r, 'cpu_system') || 0)

+ ',usage_idle=' + (mVal(r, 'cpu_idle') || 0)

+ ',usage_nice=' + (mVal(r, 'cpu_nice') || 0)

+ ',usage_iowait=' + (mVal(r, 'cpu_wio') || 0)

+ ',usage_irq=' + (mVal(r, 'cpu_intr') || 0)

+ ',usage_softirq=' + (mVal(r, 'cpu_sintr') || 0)

+ ',usage_steal=' + (mVal(r, 'cpu_steal') || 0)

+ ',usage_guest=' + (mVal(r, 'cpu_guest') || 0)

+ ',usage_guest_nice=' + (mVal(r, 'cpu_guest_nice') || 0));

}

sendToInfluxDB(msg);

}, 15);이 스크립트는 다음과 같은 몇 가지 중요한 점을 고려합니다.

sendToInfluxDB()함수는 HTTP API를 사용하여 InfluxDB로 메트릭을 POST합니다.setIntervalHandler함수는 sFlow-RT에서 메트릭 테이블을 15초마다 가져와서 Telegraf와 동일한 이름과 태그를 사용하도록 포맷팅합니다.- 스크립트는 Telegraf System 및 CPU 플러그인 기능을 구현합니다.

- 추가 메트릭을 프록시하여 추가적인 Telegraf 플러그인을 지원하는 데 쉽게 추가할 수 있습니다.

메트릭 수집을 시작하기 위해 다음 명령을 사용하여 Docker 컨테이너를 실행합니다.

docker run -v `pwd`/telegraf.js:/sflow-rt/telegraf.js \

-e "RTPROP=-Dscript.file=telegraf.js" \

-p 8008:8008 -p 6343:6343/udp sflow/sflow-rtChronograf 홈 페이지에 액세스하면 호스트의 상태와 CPU 부하가 포함된 테이블이 표시됩니다. 호스트를 클릭하면 주요 성능 메트릭을 보여주는 대시보드가 표시됩니다.

sFlow-RT의 실시간 스트리밍 분석 엔진을 사용하여 메트릭을 사전 처리하면 메트릭을 선택적으로 내보내고 데이터베이스에 로깅할 데이터 양을 줄이고 메타데이터를 추가할 수 있습니다.

예를 들어, Docker Swarm 서비스 메트릭을 수집하는 것은 sFlow-RT가 Docker Swarm 아래에서 실행되는 동적 서비스 풀을 모니터링하고 요약 통계를 InfluxDB에 작성하는 방법을 보여줍니다. 이 경우 Chronograf 대신 Grafana가 메트릭 대시보드를 구축하는 데 사용되었습니다.

또한 오픈 소스 Host sFlow 에이전트는 다양한 플랫폼으로 이식되었으며 풍부한 표준 sFlow 메트릭 범위를 내보냅니다. 표준화가 운영 복잡성을 줄이는 데 도움이 되는 방식을 설명하며, 표준 sFlow 메트릭과 Telegraf 기본 플러그인 메트릭 간의 중첩으로 프록시 작업을 간단하게 만듭니다.

Host sFlow 에이전트(및 네트워크 스위치 및 라우터에 내장된 sFlow 에이전트)는 단순한 메트릭 내보내기를 넘어 네트워크 트래픽에 대한 자세한 가시성을 제공하며, sFlow-RT 분석 소프트웨어가 자세한 트래픽 흐름 메트릭을 생성하도록 구성되어 InfluxDB로 스트리밍, 로깅(예: syslog를 사용한 이벤트 내보내기) 또는 제어 조치(예: DDoS 방어, Docker 1.12 스웜 모드 탄력적 부하 분산)를 트리거하는 방법입니다.

시스템이 대규모이거나 Elasticsearch를 운영하고 있는 환경이라면, 네트워크 트래픽 흐름 및 텔레메트리 데이터의 수집과 모니터링을 위한 강력한 도구인 ElastiFlow로 네트워크 관찰을 간편하게 수행할 수 있습니다.

이를 위해 다음과 같은 방식을 추천합니다.

- ElastiFlow 설치 및 설정:

ElastiFlow를 Elasticsearch 또는 지원하는 다른 데이터 플랫폼에 통합하려면 먼저 ElastiFlow를 설치하고 설정해야 합니다. 이를 통해 네트워크 트래픽 데이터의 수집이 시작됩니다. - 데이터 수집 설정:

ElastiFlow는 다양한 데이터 플랫폼을 지원하므로 데이터 수집 설정에서 데이터 대상 플랫폼을 Elasticsearch 또는 기타 선택한 플랫폼으로 지정해야 합니다. Elasticsearch 운영 환경을 대상으로 설정한다고 가정하겠습니다. - 네트워크 트래픽 및 텔레메트리 수집:

ElastiFlow는 설정된 데이터 플랫폼으로부터 네트워크 트래픽 흐름과 텔레메트리 데이터를 수집합니다. 이를 통해 네트워크 활동의 실시간 및 역사적인 정보를 수집하고 보관할 수 있습니다. - 대시보드 및 분석 활용:

ElastiFlow는 수집된 데이터를 기반으로 다양한 대시보드와 분석 도구를 제공합니다. 이를 통해 다음과 같은 여러 가지 용도로 네트워크 데이터를 활용할 수 있습니다:- 성능 및 가용성 모니터링: 네트워크의 성능 및 가용성을 실시간으로 모니터링하고 문제를 식별합니다.

- 용량 계획 및 비용 관리: 트래픽 패턴을 분석하여 용량 계획 및 비용 통제를 개선합니다.

- 보안: 이상한 네트워크 활동을 탐지하고 보안 위협을 식별하는 데 도움이 되며, 보안 인사이트를 제공합니다.

- 데이터 저장 및 보관:

수집된 데이터는 Elasticsearch 또는 선택한 데이터 플랫폼에 저장됩니다. 이 데이터는 장기적으로 보관하여 나중에 분석하고 보고서를 생성하는 데 사용할 수 있습니다. - 추가 구성 및 튜닝:

ElastiFlow는 다양한 구성 옵션과 튜닝 기능을 제공하므로 필요에 따라 추가 설정을 수행할 수 있습니다. 이를 통해 원하는 결과를 얻을 수 있습니다.

ElastiFlow를 통해 Elasticsearch 운영 환경에서 네트워크 플로우 데이터를 수집하고 모니터링함으로써 네트워크 성능, 가용성, 보안 및 용량 계획을 효과적으로 관리하고 최적화할 수 있습니다.

댓글