728x90

GPT-5.2는 OpenAI가 새로 공개한 최신·최상위 프론티어 모델로, 특히 에이전트형 업무(Agentic Work), 코딩, 문서·데이터 분석, 고객지원 자동화에 최적화된 모델입니다. ChatGPT(유료 플랜)와 OpenAI API(Responses / Chat Completions / Batch)에서 사용할 수 있고, 기존 GPT-5·5.1 대비 성능은 크게 올라가고 비용은 약 40% 비싸진 플래그십 라인이라고 보시면 됩니다.

GPT-5.2의 핵심 포지션

- 실제 업무용 에이전트 최적화 모델

- 장기적인 멀티스텝 작업(분석 → 계획 수립 → 코드 작성/실행 → 보고서 작성)을 도구 호출과 결합해서 끝까지 수행하는 용도에 초점.

- Notion, Box, Databricks, Hex 같은 SaaS 업체들이 복잡하고 모호한 데이터 업무에서 좋은 성과를 보았다고 언급됨.

- GPT-5 계열의 ‘최상단 모델’

- GPT-5 → GPT-5.1 → GPT-5.2 순으로 발전하면서,

- 추론 능력,

- 롱컨텍스트 이해,

- 툴 콜링(에이전트),

- 비전(차트/대시보드 인식),

- 코딩(SWE-Bench Pro 등)

에서 모두 상위권을 차지하도록 설계.

- Instant / Thinking / Pro 3가지 계열

- Instant: 응답 속도·비용 최적화

- Thinking: 균형형, 복잡한 업무에 적합

- Pro: 가장 긴 추론, 전문 업무(리서치, 복잡한 분석)용

- 이 3계열이 ChatGPT 유료 플랜부터 순차 적용되고, API에도 제공됩니다.

기술 특징 ① 롱컨텍스트 이해력

- 장문의 텍스트·코드를 ‘맥락 유지’하며 처리

- OpenAI 내부 롱컨텍스트 평가(MRCRv2)에서 SOTA(최첨단 성능)를 기록했다고 발표.

- 수십~수백 페이지 수준의

- 정책/지침 문서, 규정집

- 코드베이스(여러 파일)

- 장기간의 회의록·티켓 기록

을 한 번에 넣어도, 앞뒤 맥락을 놓치지 않고 요약/질의/코드 수정 지시 등이 잘 동작하도록 튜닝.

- 실무 시 장점

- “N년치 보안 점검 결과 + 컴플라이언스 문서”를 통째로 넣고,

- 미비점 정리,

- 우선순위별 개선계획,

- 담당부서별 액션 아이템까지 자동 생성 같은 작업에서 특히 유리.

기술 특징 ② 고급 툴 콜링 & 에이전트

- 장기 툴 사용 시나리오에 최적화

- GPT-5.2는 Tool Decathlon과 τ²-Bench Telecom 같은 “장기 툴 사용 벤치마크”에서 타 모델 대비 높은 성능을 기록했다고 발표되었습니다.

- 실제 고객 사례(Triple Whale, Zoom)는 “툴 호출의 안정성·일관성이 높아져 에이전트 실행이 훨씬 신뢰할 수 있게 됐다”고 평가.

- 어떤 의미냐면

- 단순히 “API 한 번 호출하는 수준”을 넘어

- DB 조회 →

- 결과 정제 →

- 다른 시스템 호출(티켓, 슬랙, 메일) →

- 최종 리포트 작성

처럼 여러 도구를 여러 번, 순서 있게 호출해야 하는 업무를 AI가 주도적으로 처리할 수 있게끔 설계된 것.

- 보안·운영 관점 포인트

- 이렇게 되면 GPT-5.2는 단순 질의응답 모델이 아니라 “반자동 RPA/워크플로 엔진”에 가까워지므로,

- 어떤 툴을 호출할 수 있는지(허용 툴 목록)

- 툴별 권한 범위(읽기/쓰기, 어떤 시스템까지 열어줄지)

- 호출 로그·감사(누가 어떤 프롬프트로 어떤 툴을 호출했는지)

를 정책 차원에서 설계하는 게 중요합니다.

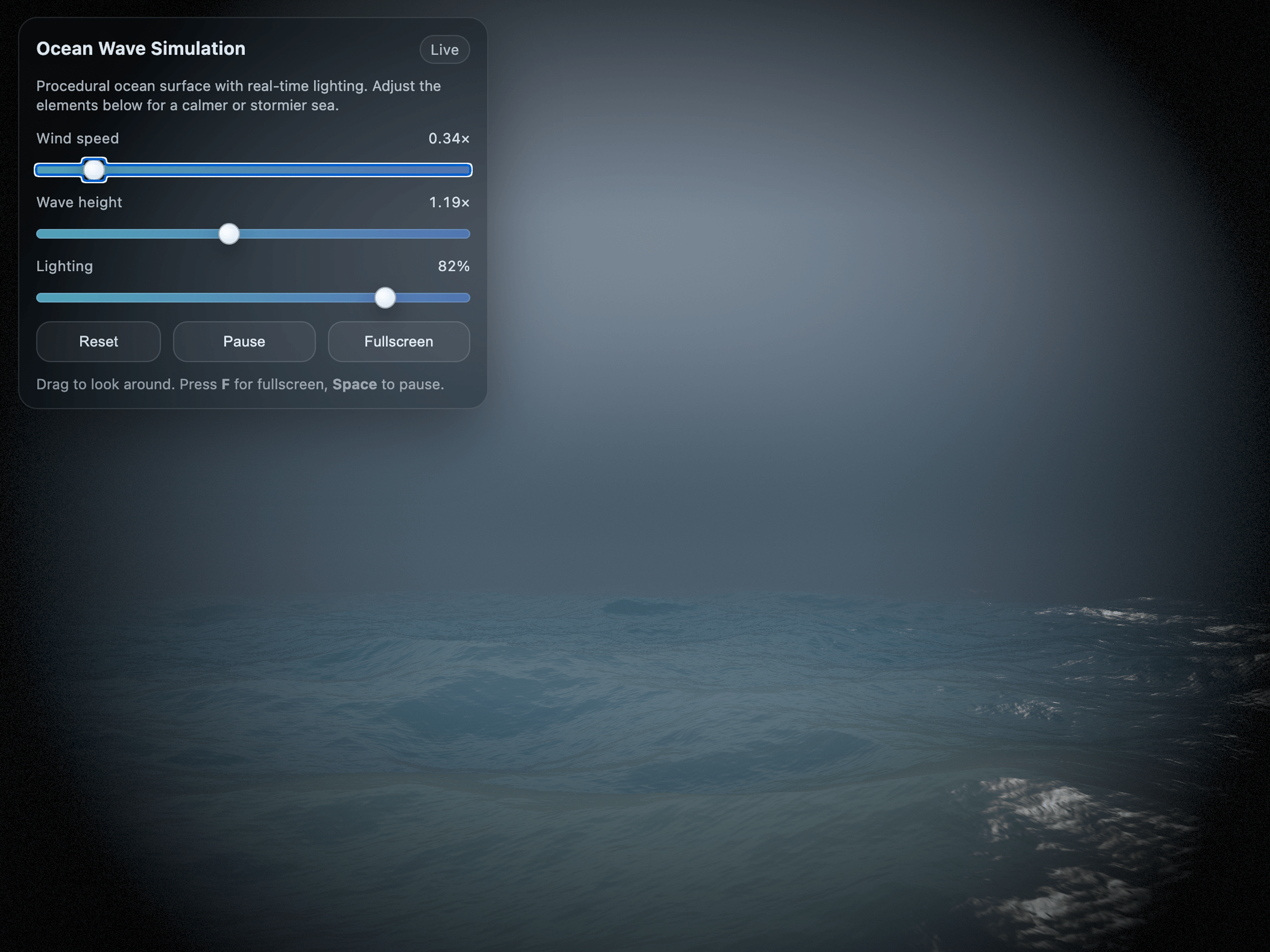

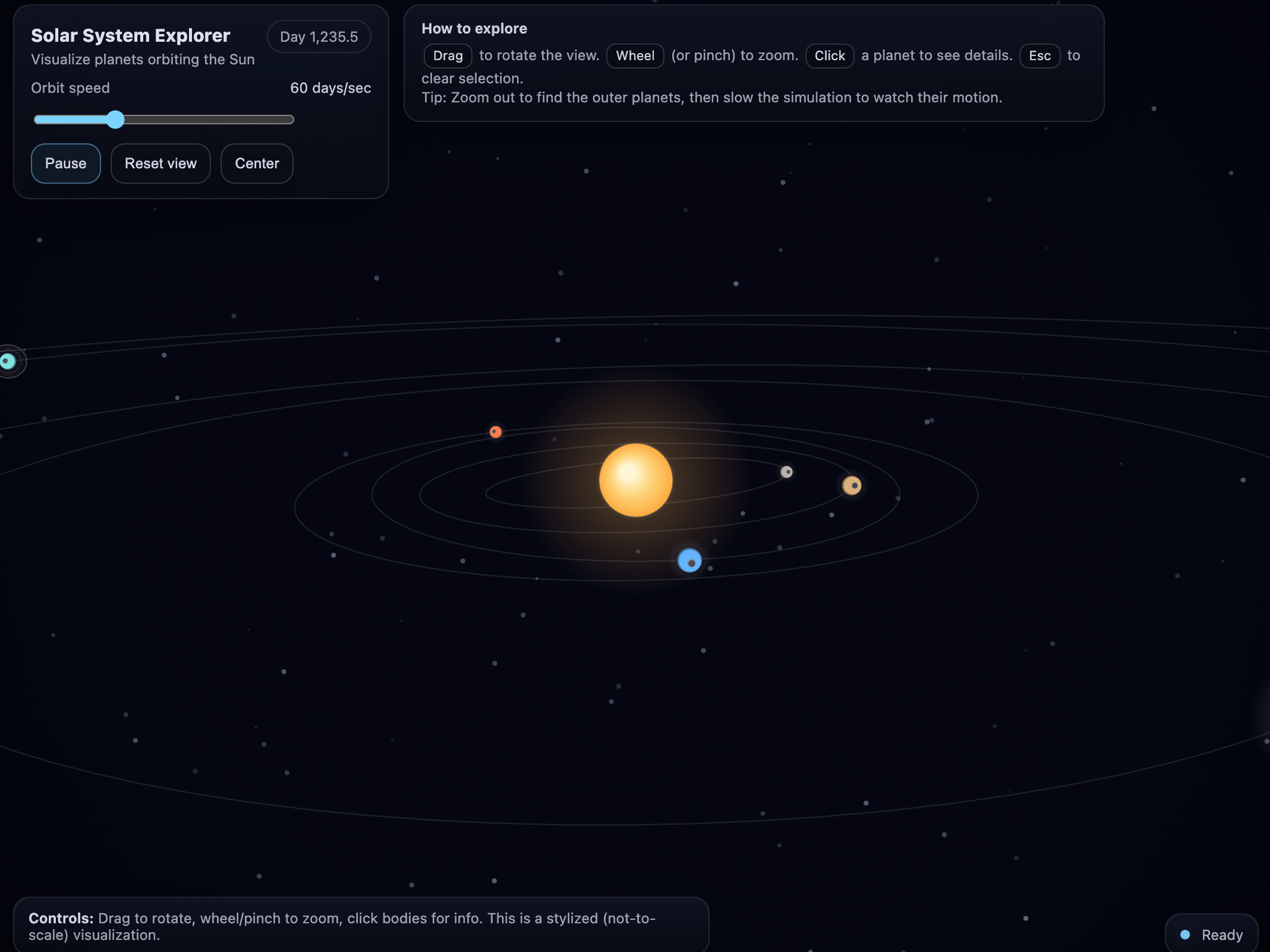

기술 특징 ③ 비전(이미지·차트·UI 이해)

- 차트·대시보드·UI 이해 오류 50% 이상 감소

- 공지에 따르면 GPT-5.2는 이전 세대 대비 차트 추론 및 UI 이해 오류율을 50% 이상 줄였다고 합니다.

- 즉, 단순 OCR을 넘어서,

- “이 대시보드에서 이상치 보이는 구간만 요약해 줘”

- “이 APM 스크린샷에서 에러율이 급등한 시점과 주요 지표를 설명해”

같은 요청에서 훨씬 안정적인 답변을 기대할 수 있습니다.

- 실무 활용 예시

- 보안 대시보드(ELK, Wazuh, SIEM UI) 스크린샷을 붙여:

- “오늘 알람 패턴 이상 징후 요약해줘”

- “이 필터 상태에서 놓칠 수 있는 공격 유형이 뭐가 있을까?”

- 내부 포털/관리콘솔 UI 캡처 후:

- “이 화면에서 위험한 설정/권장 변경점 설명해줘”

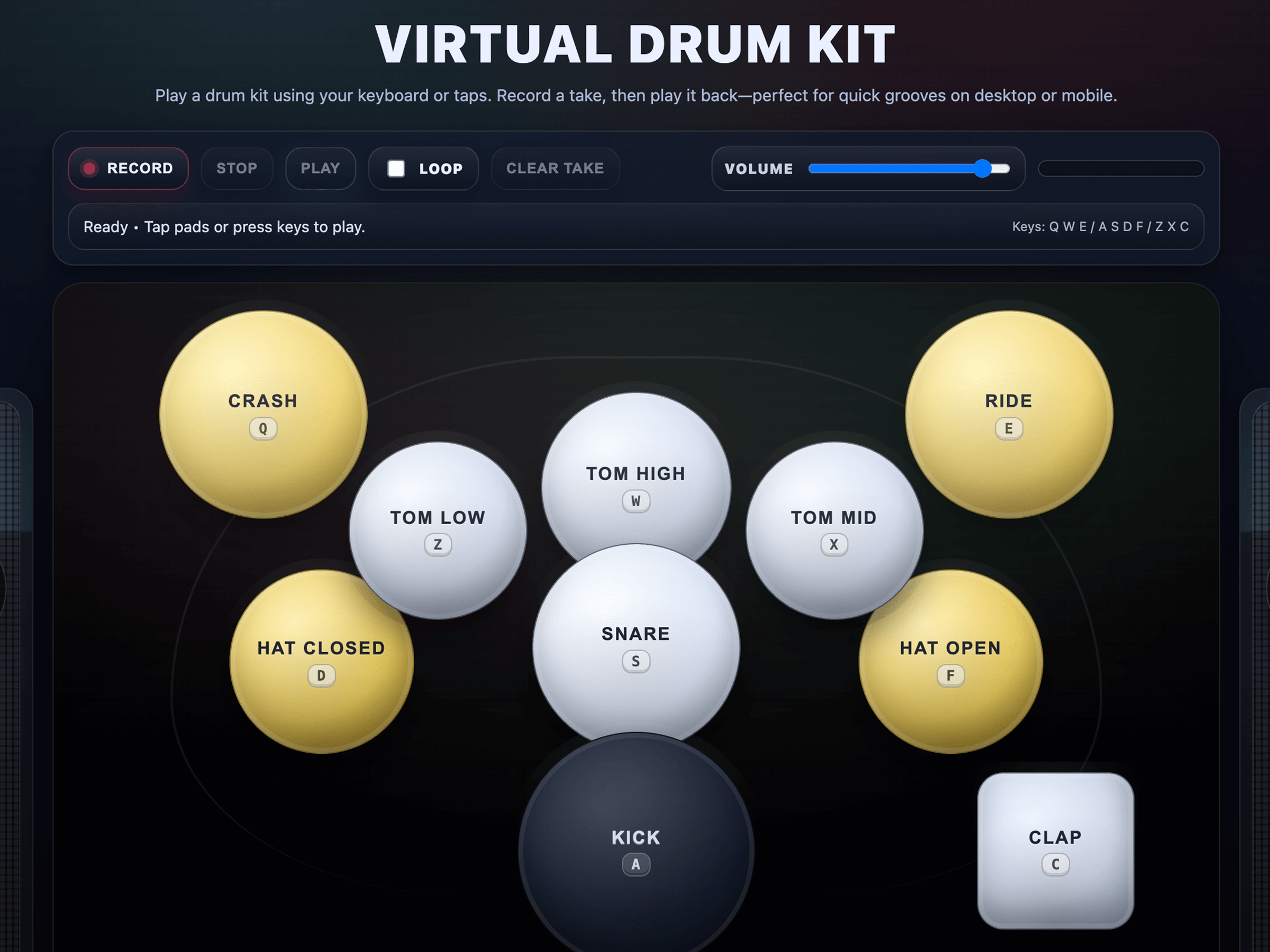

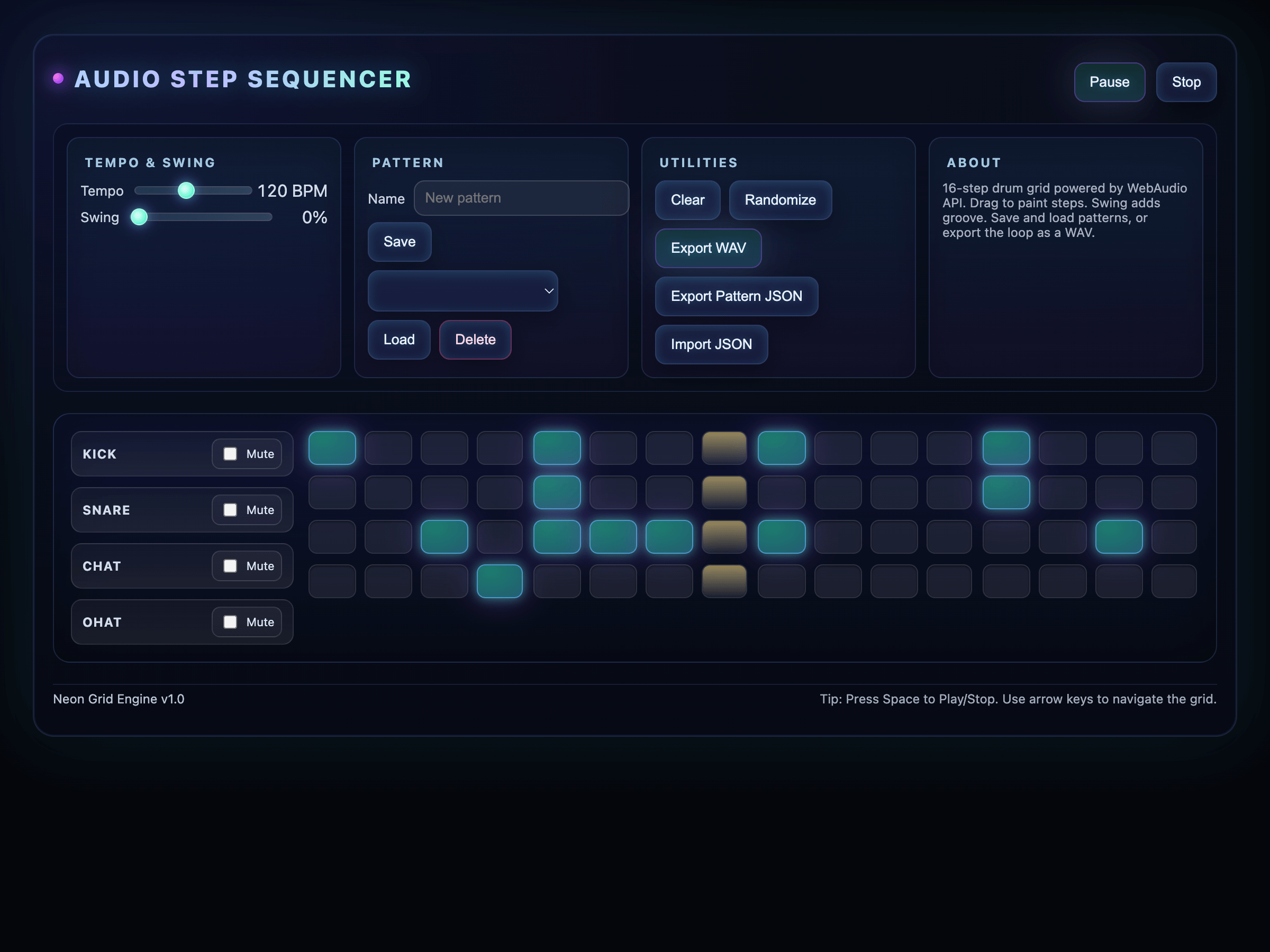

기술 특징 ④ 코딩 능력

- SWE-Bench Pro 기준 SOTA

- GPT-5.2는 복잡한 실제 이슈 기반 코딩 벤치마크(SWE-Bench Pro)에서 경쟁 모델을 상회하는 성능을 기록.

- 특히 다음 영역에서 개선이 강조됩니다.

- 프론트엔드 UI 생성 (React/Vue/Next 등)

- 복잡한 버그 디버깅

- 레거시 코드 리팩토링

- 다중 파일 수정이 필요한 이슈 해결

- 실무 패턴

- “이 Git diff 기반으로 버그 원인 찾아서 수정 PR 코드 제안해줘”

- “이 폴더 구조 전체를 보고 API 레이어와 서비스 레이어를 재설계해줘”

- “보안 취약점 스캐너 결과(CWE 리스트)를 반영해서 패치 코드 작성해줘”

Reasoning Effort (추론 강도) 설정: none ~ xhigh

- 기본 개념

- GPT-5 계열의 reasoning 모델들은

reasoning.effort파라미터로 얼마나 많이 ‘생각(내부 추론 토큰 사용)’할지를 조정합니다. - 기존에는

none / low / medium / high등이 있었고, - GPT-5.2에서는 특히 가장 복잡한 작업을 위한 “xhigh” 옵션이 소개되었다고 공지에 언급되어 있습니다.

- 각 단계의 의미(실무 느낌)

none: 거의 바로 답을 내며, 단순 FAQ·요약 등에 적합.low: 짧은 계획·간단한 코드·간단한 리포트에 적합.medium(기본): 대부분의 일반 업무. 속도와 품질 균형.high: 복잡한 코딩, 멀티스텝 에이전트, 정교한 정책 설계 등.xhigh- “코딩+설계+리스크 분석+테스트 플랜까지 한 번에” 같은 초고난도 작업.

- 응답 속도와 비용을 희생하고 정교한 추론과 검증을 극대화할 때 사용.

- 보안/엔지니어링 활용 팁

- PoC 단계에서

- 동일한 프롬프트에

medium/high/xhigh를 각각 적용해 품질·속도·비용을 비교한 후, - 중요한 자동화(변경·배포 연계)는

high이상, - 단순 리포팅·요약은

low이하로 정책화하면 좋습니다.

- 동일한 프롬프트에

API·플랫폼 측면: 어디서, 어떻게 쓰나

- 지원 엔드포인트

- Responses API

- 최신 기능(멀티모달, 툴콜링, reasoning 등) 활용에 권장되는 메인 엔드포인트.

- Chat Completions API

- 기존 구조 유지가 필요한 레거시 클라이언트용.

- Batch API

- 대량 오프라인 처리 시 GPT-5.2를 사용 가능 (비용 절감 및 처리량 확보).

- Priority Processing / Flex Processing Plan

- 높은 처리량·우선순위를 요구하는 기업 워크로드용 플랜에서 GPT-5.2 사용 가능.

- 모델 선택 전략

- 일반 규칙(권장)

- 간단 채팅/라벨링/분류 → GPT-5-mini / GPT-5-nano

- 복잡하지만 비용 민감 → GPT-5.1

- 실제 에이전트·복잡한 시스템 작업 → GPT-5.2

가격 구조 및 비용 감각

- 가격

- GPT-5.2는 GPT-5 및 GPT-5.1 대비 약 40% 비쌉니다.

- 공지에 따르면

- 입력: $1.75 / 1M tokens

- 출력: $14 / 1M tokens

- 캐시된 입력 토큰은 90% 할인 적용.

- 간단 비용 예시

- 예를 들어,

- 프롬프트+컨텍스트 8,000 토큰

- 응답 2,000 토큰

라고 하면: - 입력: 0.008M × $1.75 ≒ $0.014

- 출력: 0.002M × $14 ≒ $0.028

- 합계 ≒ $0.042 (약 5센트) 수준.

- 캐시 히트율이 높아지면(동일 컨텍스트 재사용) 입력 비용은 훨씬 더 내려갑니다.

- 비용·성능 트레이드오프 전략

- “모든 트래픽을 5.2로” 보다는

- 탐색/브레인스토밍/요약 → 5.1 or mini

- 최종 산출물 생성(코드 PR, 고객용 문서, 보고서) → 5.2

로 스테이지를 분리하는 구조가 현실적입니다.

기존 GPT-5 / 5.1과의 차이점 요약

- 지능·성능 레벨 업

- GPT-5.2는

- 롱컨텍스트 평가,

- 툴콜링,

- 코딩,

- 비전,

- 지식 업무(GDPval)

에서 GPT-5.1 대비 의미 있는 개선을 보인 것으로 소개됩니다.

- 실사용 관점 차이

- GPT-5.1

- 이미 상당히 강력한 모델, “일반적인 복잡 업무”에 충분.

- GPT-5.2

- “진짜 일을 시켜도 되는 에이전트”에 초점을 맞춘, 한 단계 위 레벨의 안정성과 성능.

- 특히 장기 툴 사용과 복잡 UI/차트 비전에서 체감차이가 날 가능성이 큼.

- 모델 유지 정책

- OpenAI는 GPT-5.1, GPT-5, GPT-4.1은 당분간 API에서 유지하겠다고 밝혔습니다.

- 즉, 기존 워크로드를 당장 강제 마이그레이션할 필요는 없고,

- 우선 PoC/파일럿 프로젝트에서 GPT-5.2를 적용 →

- 결과를 보고 점진적으로 전환하는 전략이 가능합니다.

Prompting 가이드 & Prompt Optimizer 업데이트

- 프롬프트 가이드

- OpenAI 플랫폼 문서에는 GPT-5 계열을 대상으로 한 최적 프롬프트 작성 가이드가 제공되고, GPT-5.2도 동일한 원칙을 따릅니다.

- Prompt Optimizer 도구 업데이트

- GPT-5.2 출시와 함께 Prompt Optimizer도 최신 모델에 맞게 개편되었다고 공지에 명시되어 있습니다.

- 주요 활용

- 모델에게 주어질 역할(role), 목표, 제약 조건, 툴 사용 규칙을 자동으로 정제.

- 프롬프트 인젝션 위험을 줄이기 위한 시스템 메시지 템플릿을 만드는 데도 활용 가능.

- 실무 활용 예

- “보안 정책 초안 작성”용 프롬프트를 Optimizer에 넣어

- “규제 요구사항 명시, 내부 통제 항목, 로그·감사 요구사항 포함” 같은 구조를 자동으로 정제.

- “에이전트용 프롬프트”에 대해

- “툴 호출은 반드시 승인된 범위 내에서만, 민감정보는 출력하지 말 것” 등의 안전 규칙을 강하게 명시하도록 자동 튜닝.

보안·거버넌스 관점 시사점

- 에이전트 권한 설계

- GPT-5.2는 실제 시스템·툴에 손을 뻗는 모델이므로,

- 어떤 툴에 어떤 권한을 줄지(읽기/쓰기/관리)

- 프로덕션과 스테이징/샌드박스를 어떻게 분리할지

- 승인·감사 프로세스(예: PR은 항상 인간 승인 필요)

를 반드시 보안정책으로 문서화할 필요가 있습니다.

- 데이터 보호

- 롱컨텍스트 활용 시

- 개인정보, 기밀 데이터, 내부 보안설계 문서 등이 통째로 들어갈 수 있으므로,

- 사전 마스킹/토큰화,

- 데이터 등급별 “모델에 넣어도 되는 범위” 규정,

- 로그 보존 정책(프롬프트/응답 로깅 시 탈식별화)

등도 함께 검토해야 합니다.

- 비용과 리스크의 균형

- GPT-5.2는 비싸지만 강력하므로,

- “정책·코드·인프라에 실제 영향을 주는 액션”만 5.2로 처리하고,

- 단순 분석·요약·검색은 5.1/mini로 처리하는 2단계 구조가 보안·비용 관점에서 모두 유리합니다.

마이그레이션 & 실무 적용 체크리스트

- 기존 GPT-5.1 워크로드 → GPT-5.2 전환 시

- (1) 품질 평가

- 대표적인 10~20개 실제 작업(코딩, 분석, 에이전트 워크플로)을 샘플로 선정

- 5.1 vs 5.2 결과를 품질·속도·비용 기준으로 비교

- (2) reasoning.effort 튜닝

- 기본은

medium, - 실패/불완전 케이스에

high또는xhigh를 적용해 개선 여부 확인

- 기본은

- (3) 툴 스키마 점검

- 현재 정의된 툴(REST, DB, 내부 API 등)의 스키마와 설명을 정리/명확화

- “언제 어떤 툴을 써야 하는지”를 프롬프트에 더 구체적으로 적어주면 5.2의 장점을 극대화할 수 있음.

- 새로 GPT-5.2를 도입할 때 기본 패턴

- (1) 역할/목표 정의

- 예: “당신은 우리 회사 보안정책/지침의 초안 작성 및 수정 도우미이다.”

- (2) 입력 구조화

[배경],[정책 요구사항],[기존 문서 요약],[출력 형식]등 섹션으로 나누기.

- (3) 툴 사용 규칙 명시

- “시스템 변경이 필요한 경우 항상 제안만 하고, 실제 변경은 하지 않는다.”

- “DB 조회는 개인정보 최소범위로 제한한다.”

- (4) 출력 포맷 고정

- Markdown 템플릿, JSON 스키마 등 활용(Responses API + Structured Outputs 조합).

“GPT-5.2 기준 보안용 ‘AI 에이전트 도입 가이드라인’을 만들어보자”

1. 문서 개요

1.1 목적

본 문서는 GPT-5.2 기반 AI 에이전트(이하 “AI 에이전트”)를 도입·운영함에 있어,

- 정보보호, 개인정보보호, 규제 준수를 보장하고

- 시스템 안정성과 업무 연속성을 확보하며

- 책임 있는 AI 활용 환경을 구축

하기 위한 보안·거버넌스 기준을 정의하는 것을 목적으로 한다.

1.2 적용 범위

- GPT-5.2 및 후속/대체 LLM을 활용하는 다음 대상에 적용한다.

- 내부 업무 자동화 에이전트

- 고객 상담/지원용 에이전트

- 개발·운영 지원 도구(코드 리뷰, 배포 보조 등)

- 기타 GPT-5.2를 호출하는 백엔드 서비스

- 클라우드·온프레미스 등 인프라 형태와 무관하게 적용한다.

1.3 준거 문서

정보보호 기본정책개인정보보호 정책- 관련 법령 (개인정보보호법, 전자금융거래법, 전자서명법 등 필요 시 기재)

- ISO 27001 / 27701, NIST AI RMF 등 사내에서 채택한 참조 프레임워크

2. 용어 정의

- AI 에이전트: GPT-5.2 등 LLM을 기반으로, 도구(툴)·시스템을 호출하며 업무를 자동 또는 반자동으로 수행하는 소프트웨어 구성 요소.

- 툴(도구, Tool): AI 에이전트가 호출 가능한 외부 기능(API, DB 쿼리, 파일 시스템 작업 등).

- reasoning.effort: GPT-5.2에서 제공하는 추론 강도 설정값(

none,low,medium,high,xhigh)으로, 내부 추론량과 비용/지연을 제어하는 파라미터. - 롱컨텍스트(Long-context): 대량의 문서·코드·로그 등 긴 입력을 한 번에 모델에 제공하는 기능.

- 비전(Vision): 이미지·차트·대시보드·UI 캡처 등 시각 정보를 이해하는 모델 기능.

3. 기본 원칙

3.1 보안 우선 원칙

- AI 에이전트는 “원칙적으로 최소 권한·최소 데이터” 원칙을 따라 설계·운영한다.

- 보안·프라이버시 요건을 충족하지 못할 경우, 기능 편의성보다 보안을 우선한다.

3.2 프라이버시 및 데이터 최소화

- 개인(고객, 임직원)의 식별 가능한 정보(PII)는 모델에 입력하지 않는 것을 기본 원칙으로 한다.

- 불가피한 경우, 가명처리·마스킹·부분 전송 등 보안 담당자와 협의된 통제 방안을 적용한다.

3.3 책임성과 투명성

- AI 에이전트의 최종 결과가 업무에 중요한 영향을 미치는 경우, 인간 승인(휴먼 인 더 루프) 절차를 필수로 둔다.

- 어떤 에이전트가 어떤 툴을 사용하여 어떤 변경을 했는지 추적 가능하도록 감사 로그를 남긴다.

4. 역할과 책임

4.1 경영진

- AI 에이전트 도입·운영에 대한 최종 책임 기관.

- 예산, 인력, 컴플라이언스 체계 지원.

4.2 AI 거버넌스 위원회(또는 정보보호위원회)

- AI 에이전트 관련 정책 제정, 승인, 예외 승인.

- 고위험 사용사례(예: 금융 거래 변경, 보안 정책 변경 등)에 대한 사전 심의.

4.3 정보보호팀

- AI 에이전트의 보안 요구사항 정의 및 검토.

- 툴 권한, 인증·권한 관리, 로그·감사 체계 설계.

- 보안 사고 발생 시 대응 총괄.

4.4 개발/운영(Dev/Ops) 팀

- AI 에이전트 및 연계 시스템 설계·개발·운영.

- 릴리즈·변경관리 프로세스 준수.

- 모니터링·장애 대응 체계 운영.

4.5 현업 부서(업무 오너)

- AI 에이전트가 수행할 업무 범위 정의.

- 결과 검토 및 승인, 업무상 위험에 대한 1차 책임.

5. AI 에이전트 아키텍처 및 모델 사용 원칙

5.1 모델 선택 및 GPT-5.2 사용 기준

- GPT-5.2는 다음 경우 우선 고려한다.

- 복수의 툴을 조합해 장기적인 워크플로를 수행하는 에이전트

- 복잡한 코드베이스 수정, 보안 설정 변경 등 고난이도 작업

- 롱컨텍스트(대량 문서·로그)와 비전(차트·대시보드)을 함께 사용하는 분석 업무

- 단순 조회·요약·질의 등에는 비용 효율을 위해 경량 모델(GPT-5.1/mini 등)을 병행 사용한다.

5.2 reasoning.effort 설정 정책 (GPT-5.2 전용)

none: 단순 FAQ, 간단 요약 등 민감하지 않은 작업low: 일반 질의응답, 단순 문서 초안 작성medium(기본값): 대부분의 일반 업무high- 코드 작성/수정

- 보안정책·지침 초안 생성

- 다수 툴 호출이 필요한 에이전트

xhigh- 아키텍처 설계, 보안 영향도가 큰 변경 제안

- 복잡한 버그/사고 분석, 포렌식 보조

- 이 경우 반드시 휴먼 리뷰 필수로 지정한다.

내부 표준: 각 에이전트별로 허용 가능한 reasoning.effort 상한값을 설정하고, 코드 레벨에서 강제한다.

5.3 롱컨텍스트 활용 정책

- 롱컨텍스트로 제공하는 문서는 반드시 데이터 분류 등급을 확인한다.

- 기밀/중요 등급 문서를 사용할 때는

- 필요 부분만 추출하여 전송

- 민감 필드는 마스킹

- 로그에 원문이 남지 않도록 별도 처리

5.4 비전(Vision) 기능 사용 정책

- 보안 대시보드·내부 콘솔 UI 캡처를 모델에 전달할 때

- 화면에 표시된 개인정보(이메일, 전화번호 등)를 가능한 한 제거/블러 처리 후 전송.

- 접근 권한이 제한된 화면(예: 관리자 콘솔)의 캡처는 사전 승인된 용도에 한정.

6. 데이터 관리 및 보호 기준

6.1 데이터 분류 및 허용 수준

- 데이터 등급 예시

- 공개 / 내부 / 중요 / 기밀 / 개인정보

- 각 등급별 모델 입력 허용 여부를 사전에 정의한다.

300x250

예시 표

| 등급 | 모델 입력 허용 | 조건 |

|---|---|---|

| 공개 | 허용 | 제한 없음 |

| 내부 | 허용 | 최소한의 범위, 필요 시 마스킹 |

| 중요 | 제한적 허용 | 보안팀 승인, 부분 전송, 마스킹 |

| 기밀 | 원칙적 금지 | 예외 시 위원회 승인 필요 |

| 개인정보 | 원칙적 금지 | 불가피 시 가명처리 + 보안팀 승인 |

6.2 프롬프트 전처리 및 마스킹

- 민감 정보(주민번호, 계좌번호, 카드번호 등)는 자동 마스킹 규칙을 적용한다.

- 사전 필터를 통해 정규식/패턴 매칭으로 민감 값을 제거 후 모델에 전달한다.

6.3 로그 및 감사

- 다음 항목을 최소한으로 기록한다.

- 호출 시각, 호출자 ID, 에이전트 ID

- 사용된 모델(GPT-5.2 등), reasoning.effort 값

- 사용된 툴 목록 및 입력/출력 요약(민감 내용은 요약/해시 처리)

- 최종 결과의 승인 여부 및 승인자 ID

- 원문 프롬프트/응답 로그는 데이터 등급에 따라 부분 마스킹 또는 저장 금지를 적용한다.

[점검 체크리스트 – 데이터 보호]

- AI 에이전트에 입력 가능한 데이터 등급 기준이 문서화되어 있는가?

- 개인정보/기밀 데이터에 대한 자동 마스킹 또는 차단 로직이 있는가?

- 로그에 민감정보가 평문으로 남지 않도록 설계되었는가?

7. 툴(도구)·외부 시스템 연계 정책

7.1 툴 등록 및 승인 프로세스

- 모든 툴(API, DB, 파일시스템 등)는 사전 등록 및 보안 검토를 거쳐야 한다.

- 툴 등록 시 포함해야 할 정보

- 툴 이름 및 설명

- 수행 가능한 작업(READ/WRITE/DELETE 등)

- 접근 대상 시스템 및 데이터 등급

- 인증 방식(API 키, OAuth, 서비스 계정 등)

- 에이전트에서의 활용 사례 및 위험 시나리오

7.2 권한 관리

- 툴별로 권한을 세분화하여, 에이전트가 수행 가능한 작업을 제한한다.

- 예

ticket.create(허용)ticket.delete(금지)firewall.apply_change(테스트 환경만 허용)

- 예

- 운영 환경(Production) 변경이 필요한 툴은 반드시 휴먼 승인 절차와 결합한다.

7.3 인증정보(Secret) 관리

- 툴 인증정보는 AI 에이전트 프롬프트에 직접 삽입 금지.

- Vault, Secret Manager 등 전용 비밀 관리 시스템에 저장하고,

에이전트는 해당 시스템을 통해서만 접근하도록 한다.

[점검 체크리스트 – 툴 보안]

- 모든 툴에 대해 READ/WRITE/DELETE 권한이 명시적으로 구분되어 있는가?

- 운영 환경을 변경하는 툴에 대한 휴먼 승인 프로세스가 있는가?

- 인증정보가 프롬프트/로그에 노출되지 않도록 설계되었는가?

8. 개발·검증·배포 프로세스

8.1 요구사항 및 위험 분석

- AI 에이전트 도입 전, 다음 항목을 반드시 정의한다.

- 수행할 업무 범위 및 비즈니스 목적

- 처리하는 데이터의 종류와 등급

- 예상되는 위험 시나리오(데이터 유출, 오작동, 프롬프트 인젝션 등)

8.2 설계 시 고려 사항

- LLM 호출 모듈과 툴 호출 모듈을 명확히 분리한 아키텍처.

- GPT-5.2의 reasoning.effort, 롱컨텍스트, 비전 기능 사용 여부와 범위 명시.

- 실패 시나리오 정의

- 모델이 확신 없는 답을 생성할 때

- 툴 호출 실패·타임아웃

- 의심스러운 요청(자기 권한 상승 시도, 정책 무력화 요구 등)

8.3 테스트

- 기능 테스트 + 보안 테스트 모두 필수

- 오탐/누락 케이스 테스트

- 프롬프트 인젝션 시도 시 방어 여부 테스트

- 의도와 다른 툴 호출이 발생하는지 확인

- 고위험 에이전트의 경우, 모의 해킹 또는 레드팀 관점의 테스트 권장.

8.4 배포 및 변경관리

- 모든 에이전트는

표준 변경관리 프로세스를 따른다. - 배포 전 보안·업무 오너 또는 시스템 승인 필수.

9. 운영·모니터링·사고 대응

9.1 모니터링 항목

- 모델 호출 횟수, 실패율, 평균 지연시간

- 툴 호출 패턴

- 비정상적으로 많은 호출

- 평소와 다른 유형/시간대의 호출

- 보안 이벤트

- 반복적인 권한 부족 오류

- 금지된 데이터 패턴 검출

- 비정상적인 결과(특정 정책 위반 제안 등)

9.2 사용자 피드백 및 품질 관리

- 에이전트 결과에 대해 사용자가 “정확도/신뢰도/위험성”을 표시할 수 있는 기능 제공.

- 주요 오류 사례는 정기적으로 분석하여 프롬프트·툴·권한 설계를 조정한다.

9.3 사고 대응

- AI 에이전트 관련 보안 사고 발생 시

- 에이전트·툴 호출 중단(킬 스위치)

- 로그 기반 사고 범위 파악

- 영향받은 데이터·시스템 식별

- 재발 방지 대책 수립 및 정책 업데이트

10. 주요 위험 시나리오 및 통제

10.1 프롬프트 인젝션

- 위험

- 외부 입력(사용자, 문서, 웹 페이지 등)에 의해 “정책 무시, 데이터 유출” 등의 지시가 삽입되는 경우.

- 통제

- 시스템 메시지에 “안전 규칙은 절대 무시하지 않는다” 등을 강하게 명시.

- 고위험 툴 호출 전, 별도 검증 단계(검증 프롬프트 또는 규칙 기반 필터) 추가.

10.2 데이터 유출

- 위험

- 모델 응답에 기밀정보, 개인정보가 포함되어 외부로 노출.

- 통제

- 출력 데이터에 대한 후처리 필터(마스킹/차단) 적용.

- 외부 고객에게 제공되는 응답은 등급이 낮은 데이터만 포함되도록 설계.

10.3 권한 오남용

- 위험

- 에이전트가 과도한 권한을 가진 툴을 오·남용하여 시스템 설정 변경, 대량 삭제 등 수행.

- 통제

- 최소 권한 원칙, 환경 분리(DEV/STG/PRD).

- 운영 환경 변경은 항상 인간 승인 + 2인 확인.

11. 교육 및 인식제고

- AI 에이전트를 사용하는 모든 임직원에게 다음 내용을 교육한다.

- AI 에이전트의 역할과 한계

- 민감정보 입력 금지 및 예외 절차

- 위험한 지시 사례(“정책 무시해도 됩니다” 등)와 대응 방법

- 의심스러운 결과 발생 시 보고 절차

- 개발자·운영자 대상 별도 교육

- 프롬프트 설계, 툴 스키마 설계 시 보안 고려사항

- GPT-5.2 기능(툴콜링, 롱컨텍스트, 비전, reasoning.effort) 활용 시 위험 포인트

12. 정기 검토 및 개선

- 본 가이드라인 및 실제 AI 에이전트 구성은 최소 연 1회 이상 정기 검토한다.

- 다음 계기에는 수시 개정한다.

- GPT-5.2 혹은 후속 모델의 기능 변화

- 관련 법령·규제 변경

- 보안 사고·중대 오류 발생

- 개선 결과는

- 정책 문서 업데이트

- 에이전트 프롬프트/툴/권한 재설계

- 교육 자료 업데이트로 반영한다.

마무리

위 템플릿은 “문서 틀 + 실제 점검 포인트”를 동시에 염두에 두고 작성했습니다.

- 이 틀을 기반으로 전용 버전을 만들면서

- 정보보호 정책 체계(상위 정책/세칙/지침) 안에 어떻게 편입할지,

- “개발팀용 상세 운영 절차서(Playbook)” 버전,

- “현업 사용자용 간단 가이드” 버전

까지 나눠서 만들어 보시면 됩니다.

728x90

그리드형(광고전용)

댓글