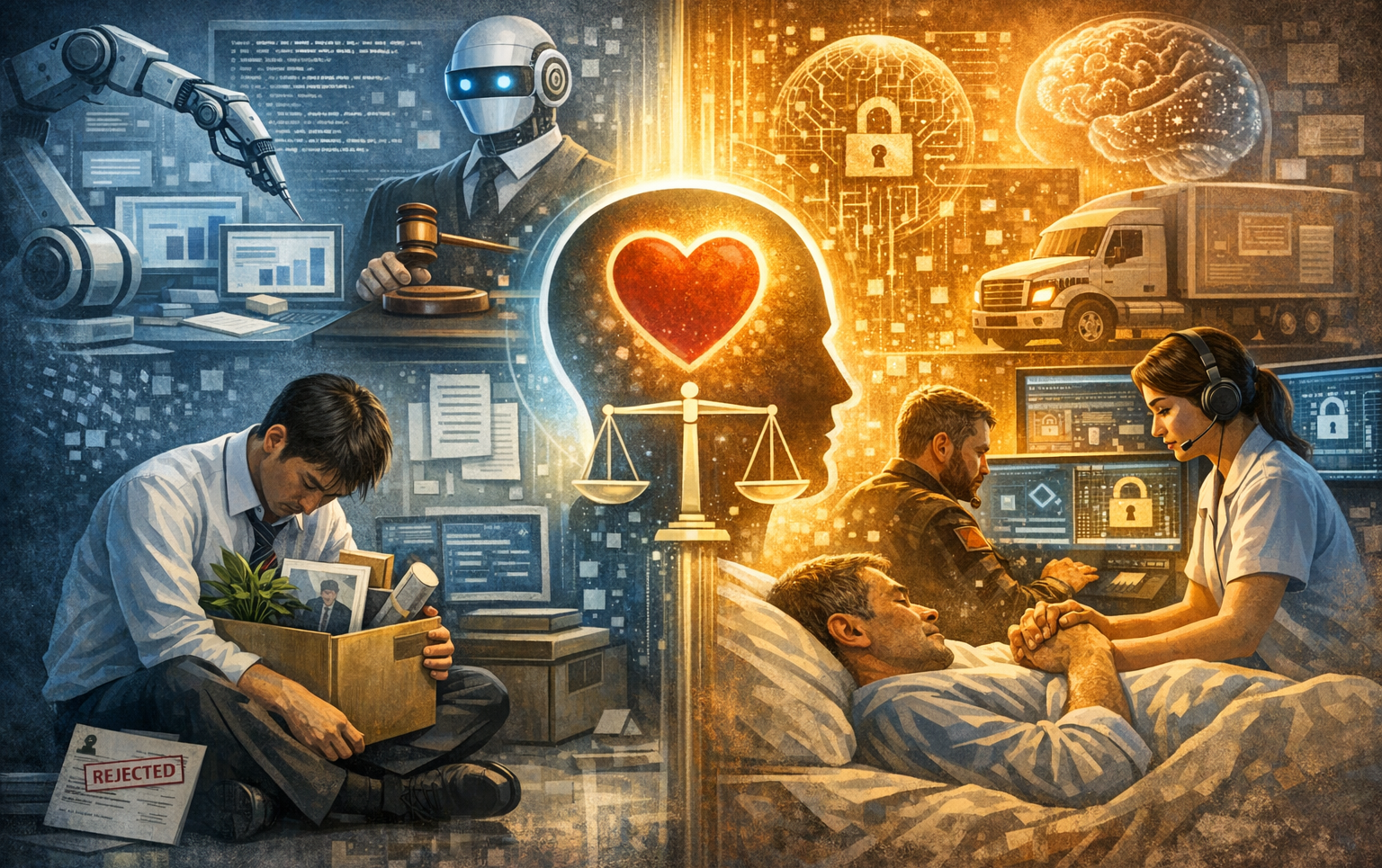

“AI가 일자리를 대체하면서 생기는 불안·허탈감”을 중심으로, 직업군별 취약/안전 요인, 사람 심리의 변화, 조직·개인의 적응 전략, 그리고 “그럼 인간만이 할 수 있는 역할은 무엇이고, 우리는 무엇을 해야 하는가?”

왜 지금 ‘불안·허탈감’이 보편 감정이 되었나

충격의 특징: “화이트칼라가 먼저 흔들림”

- 과거 자동화는 주로 반복적인 육체노동/정형업무를 대체했는데, 생성형 AI는 문서·기획·분석·코딩·요약·상담처럼 “지식노동의 핵심”을 빠르게 잠식합니다.

- 특히 초년/주니어 업무(자료조사, 초안 작성, 테스트/리포트, 표준계약서 수정 등)가 통째로 압축되며, “경력 사다리”가 흔들리는 양상이 강합니다. 미국 백악관 경제자문위원회(CEA)도 AI 노출이 큰 직무군에서 취약 신호를 실증적으로 다룬 바 있습니다.

“일자리 감소”는 단일 숫자가 아니라, ‘구성의 변화’

- 골드만삭스는 생성형 AI가 전 세계적으로 상당한 규모의 업무를 대체/자동화 노출시킬 수 있다고 분석했고(전일제 일자리 환산 3억 노출 추정), 동시에 생산성/신규 업무도 함께 발생할 수 있음을 같이 봅니다.

- 맥킨지도 “AI 투자 대비 실제 성숙도는 매우 낮다”는 진단과 함께, 확산 국면에서 리더십/운영체계 부재가 혼란을 키운다고 봅니다.

대표 ‘취약 직업군’이 흔들리는 이유

아래는 “직업 리스트”보다 더 중요한 취약 패턴(왜 취약한가) 중심으로 정리합니다.

개발자/프로그래머(특히 주니어)

취약해지는 이유(패턴)

- 주니어의 주업무(보일러플레이트 작성, CRUD, 테스트 초안, 문서화, 디버깅 보조)가 AI로 압축

- 팀이 “사람을 뽑아 키우는 비용” 대신 “AI+시니어로 생산량”을 끌어올리는 선택을 하기 쉬움

➡️ 결과: 채용 축소가 ‘신입’에 먼저 반영되는 구조

하지만 동시에 생기는 기회

- 시스템 복잡도가 증가할수록 아키텍처/보안/신뢰성/데이터 품질은 더 중요해짐

- “코드 작성자”보다 “문제 정의·품질 보증·운영 설계”가 가치가 됨

변호사/회계사(초안·리서치 업무 중심)

- 실제로 법률/회계 영역에서도 표준 문서 초안 작성·요약·번역·리서치가 AI로 대체되며 인력 구조를 바꾸려는 움직임이 보도됩니다.

- 핵심은 “전문직이 안전/위험”이 아니라, 전문직 내부에서도 업무가 쪼개져

- (취약) 표준/정형/리서치/초안

- (강함) 책임 있는 자문, 이해관계 조정, 소송 전략, 리스크 감수 판단

으로 재배치된다는 점입니다.

마케터/콘텐츠(대량 생산·AB 테스트형 업무)

- 카피/썸네일 문구/랜딩 문구/콘텐츠 초안/요약·재가공은 AI가 매우 강합니다.

- 반면 “브랜드의 방향성/금기선/사회적 파장/규제 리스크”는 여전히 사람이 책임져야 합니다.

상담원·통역·운전 등(패턴/반복 + 규모 경제)

- “규모가 크고 반복”일수록 자동화 압력이 강합니다.

- 다만 고객 분쟁/감정 폭발/예외 케이스/현장 변수는 사람이 맡는 쪽으로 재편됩니다.

사람들이 느끼는 불안·허탈감의 ‘정체’(심리 메커니즘)

“통제감 상실”이 핵심

- 인간은 “노력 → 실력 → 보상”의 연결이 있을 때 버팁니다.

- 그런데 AI는 노력의 축적이 시장가치로 전환되는 규칙을 갑자기 바꿉니다.

➡️ 그래서 불안은 단순히 돈 문제가 아니라 자존감/정체성(내가 누구인가) 문제로 번집니다.

“예측 불가능성”이 공포를 키움

- 내 산업이 2년 뒤 어떻게 될지, 내 직무의 ‘어느 조각’이 사라질지 불명확합니다.

- Pew 설문에서도 노동자들이 AI의 직장 영향에 대해 우려가 상당히 크다는 결과가 나옵니다.

“AI 의존”은 불안을 줄이기도, 키우기도 함

- 불안이 큰 사람일수록 즉각적 위로/정답을 주는 대상에 의존하기 쉬운데,

- AI는 즉시 반응하지만 관계의 상호책임이 없어서, 장기적으로 고립/의존의 루프가 생기기도 합니다.

그래서 “인간만이 할 수 있는 역할”은 정확히 무엇인가

여기서 중요한 포인트는, “AI가 못하는 것”이 아니라 “AI가 해도 ‘책임질 수 없는 것’”이 인간의 영역이 된다는 점입니다.

책임(Accountability)과 최종 의사결정

AI는 판단을 만들 수 있어도, 법적·윤리적 책임의 주체가 될 수 없습니다.

- 예: “이 계약 조항을 넣을까요?”

- AI: 초안/리스크 목록 제시 가능

- 인간: 회사의 리스크 허용도(돈/평판/소송)를 감수하고 결정

- 예: “이 보안 사고를 공지할까요?”

- AI: 템플릿 작성 가능

- 인간: 규제/고객 신뢰/2차 피해를 고려해 공개 범위 결정

결론: “결정권자, 책임자” 역할은 더 비싸집니다.

문제 정의(Problem Framing)와 목표 설정

AI는 “잘 정의된 문제”에 강합니다.

하지만 현실의 일은 대개 문제가 정의되지 않은 채 시작합니다.

- 예: “매출이 떨어졌어”

- 이게 가격 문제인지, 브랜드 신뢰 문제인지, 제품 경험 문제인지부터 정의해야 합니다.

- 예: “보안이 불안해”

- 위협모델/자산가치/공격표면/우선순위를 정하는 게 먼저입니다.

인간의 가치는 “답”이 아니라 ‘무엇을 물어야 하는가’를 정하는 능력로 이동합니다.

이해관계 조정·협상·리더십(사람 사이의 일)

조직에서 큰 일은 늘 “기술”이 아니라 “사람”에서 막힙니다.

- 부서 갈등, 예산, 책임 떠넘김, 우선순위 전쟁, 감정 문제

이건 AI가 대체하기 어렵습니다.

AI 시대일수록 조율자/리더/PM/보안 거버넌스 가치가 오릅니다.

윤리·규범·사회적 파장 판단

AI는 데이터 기반 최적화는 잘하지만,

- 차별/편향

- 악용 가능성

- 사회적 논란

- 규제 준수

같은 영역은 정답이 하나가 아니라 합의와 책임의 문제입니다.

그래서 “AI 윤리/거버넌스”가 신규 영역으로 커지고, 조직 내 통제 필요성이 커집니다.

현장 판단(예외 케이스, 물리 세계, 즉시 대응)

응급, 장애 대응, 보안 사고, 고객 분쟁처럼 예외·돌발·고압 상황은 “현장 인간”이 강합니다.

- 보안 사고 대응은 특히 상황이 매번 다르고, 공격자가 인간이라 변칙이 많습니다.

- “AI가 분석”은 보조가 될 수 있어도, 최종 대응 설계/의사결정/커뮤니케이션은 사람이 해야 합니다.

“그럼 우리는 무엇을 해야 하나?”

개인 전략: “AI와 경쟁”이 아니라 “AI를 포함한 역할 재설계”

아래 3가지를 동시에 가져가면 강해집니다.

- 도메인 깊이(업의 본질)

- 보안이면 위협모델, 리스크, 규제, 사고 대응, 통제 설계

- 법률이면 판례 암기보다 “비즈니스 리스크/협상/전략”

- AI 활용 숙련(생산성 레버리지)

- 내 결과물이 “AI로 만든 초안”에서 끝나면 누구나 할 수 있습니다.

- “AI 결과물을 검증·개선·책임형 산출물로 바꾸는 능력”이 차이를 만듭니다.

- 책임 영역 확보(의사결정/품질/거버넌스)

- “나만 할 수 있는 결정”을 가져가야 합니다.

- 예: 보안팀이라면 AI 사용 정책, 데이터 반출 통제, 프롬프트 인젝션 대응, 모델 리스크 평가 같은 영역이 딱 그 포지션입니다.

조직 전략: “도입”보다 “운영체계”가 승패를 가름

AI 도입이 커질수록, 조직은 아래를 반드시 갖춰야 합니다.

(1) AI 사용 정책 + 데이터 보호(보안 관점 핵심)

- 기밀/개인정보/소스코드 입력 금지 기준

- 승인된 툴/계정/로깅

- 결과물 출처/검증 책임

기업들이 실제로 정보 유출 우려로 사용 통제를 고민해온 흐름도 있습니다.

(2) “검증 가능한 업무 프로세스”로 재설계

- AI가 만든 산출물은 항상 검증 단계가 있어야 합니다.

- 특히 법무/보안/재무처럼 사고가 치명적인 영역은

- 2인 검토

- 근거 링크/로그 보관

- 승인 라인

같은 감사 가능성이 중요합니다.

(3) 사람 재교육의 방향 전환: ‘툴 교육’이 아니라 ‘역할 교육’

- “프롬프트 잘 쓰기”만 가르치면 금방 평준화됩니다.

- 대신

- 문제정의

- 품질검증

- 리스크 판단

- 이해관계 조정

같은 “사람 역할”을 강화해야 합니다.

“인간만이 해야 하는 일”을 직무 시나리오로 보기

예시 A) 개발 조직

- AI가 하는 일: 코드 초안/테스트 생성/문서화

- 인간이 해야 하는 일(가치 상승)

- 이 변경이 보안/성능/운영/장애에 미치는 영향 판단

- 요구사항을 “애매함 → 명세”로 변환

- 품질 기준(테스트/관측성/롤백)을 설계

예시 B) 법무/회계

- AI가 하는 일: 초안/리서치/요약/번역

- 인간이 해야 하는 일

- 회사가 감수 가능한 리스크 경계선을 정하고 협상

- 분쟁 시나리오별 비용/평판/선례를 종합해 결정

(전문직의 업무 재편 흐름은 국내 기사에서도 관찰됩니다.)

예시 C) 마케팅/콘텐츠

- AI가 하는 일: 대량 콘텐츠/카피 변형/요약

- 인간이 해야 하는 일

- 브랜드 톤·가치·금기선을 정하고 최종 승인

- 사회적 논란/규제 리스크를 고려한 캠페인 설계

예시 D) 보안팀

- AI가 하는 일: 경보 요약, IOC 분류, 리포트 초안, 쿼리 생성

- 인간이 해야 하는 일(핵심)

- 위협모델/우선순위/통제 설계

- AI가 만든 분석의 오탐/환각 검증

- 사고 대응 시 조직 커뮤니케이션/대외 공지/법적 리스크 결정

- AI 사용으로 늘어나는 리스크(데이터 유출, 프롬프트 인젝션, 공급망)를 정책과 기술로 통제

“AI가 대체 못하는 직업”보다 중요한 질문

많은 글이 “안전 직업 리스트”를 줍니다. 하지만 더 중요한 건 이 질문입니다.

내 직업이 안전한가?

아니라, 내 업무 중 ‘책임·판단·조율·문제정의’ 비중을 얼마나 키울 수 있는가?

AI는 일을 없애기만 하기보다, 일을 재조합합니다.

그리고 그 재조합의 중심에는 늘 “인간이 책임져야 하는 것들”이 남습니다.

그 영역으로 이동하는 사람이, 결국 AI 시대의 승자 포지션을 차지합니다.

댓글